Motto:

Systemy komunikacji za pośrednictwem komputerów nie oznaczają całkowitego zastąpienia wszystkich innych form komunikacji. Zarówno kadry wykonawcze, jak i kierownicze do określonych celów będą ciągle używać telefonów, będą się spotykać i pisać listy. Jeśli jednak mądrze użyć tych systemów, to ilość koniecznych podróży i spotkań może zostać znacząco obcięta, wspierając zwoływanie bardziej produktywnych spotkań twarzą–w-twarz przez wcześniejsze ustanowienie wspólnej bazy informacyjnej.

Hiltz S.R., Turoff M., "The network nation: Human communication via computer”, 1978: 139.

Od wieków zdawano sobie sprawę z faktu, że samo

wytwarzanie dóbr nie przynosi dobrobytu i budowa dobrego środowiska

komunikacyjnego jest warunkiem rozwoju. Dobra droga była równie bezcenna zarówno

dla transportu żywca jak i urobku górniczego. Inwestowanie w komunikację (budowa

dróg, mostów, kanałów śródlądowych, sieci telegraficznej, telefonicznej,

satelitarnej) zawsze było opłacalne i finansowane z centralnych (królewskich,

rządowych) funduszy. Jednak prawie każda próba połączenia różnych systemów

pociągała za sobą niebagatelne problemy. Przekonała się o tym najlepiej

porozbiorowa Polska.

Im więcej różnic występuje między współpracującymi

systemami, tym więcej trzeba wprowadzać elementów dopasowujących. Zabieg ten

podraża koszty integracji całego systemu i jego eksploatacji. Jako negatywny

przykład może tu służyć rozbieżność normatywów szyn kolejowych na terenie Rosji

i w pozostałej części Europy. Jako przykład pozytywny może tu służyć unifikacja

napięć przesyłowych w liniach wysokiego napięcia krajów europejskich pozwalająca

błyskawicznie usuwać okolicznościowe (transmisje meczy piłkarskich w telewizji)

niedobory energetyczne. Mimo wielkich kosztów, Wielka Brytania przeszła na

dominujące w świecie systemy metryczne miar, wag i waluty, ale nie zdobyła się

na zmianę kierunku ruchu z lewostronnego na prawostronny. Zdobyła się natomiast

na to Szwecja, przy okazji obdarowując Pakistan autobusami z kolumną kierownicy

wbudowaną po prawej stronie.

Odwołaliśmy się powyżej do jednego z

elementów komunikacji. Był to transport i jego otoczenie logistyczne (różnego

rodzaju drogi, mosty, infrastruktura techniczna i prawna). Transport jest

organizowany dla pewnego systemu dostawców i odbiorców. Dostawcy

to zbiór elementów o podwyższonym potencjale energetycznym, materialnym,

ludzkim, produkcyjnym, informacyjnym, czy organizacyjnym; - odbiorcy to elementy

innego zbioru o obniżonym potencjale. Odbiorcą może być oferent wartości

dodanej lub konsument produktu końcowego. Transport obiektu może być

utrudniony przez fizyczne gabaryty (ropa naftowa) lub nie mieć tego

ograniczenia (głos). W szczególnym wypadku dostawca może być wyposażony w

urządzenie do wysyłki, którego istotnym elementem jest nadajnik, a

odbiorca w urządzenie umożliwiające przejęcie przesyłki wyposażone w

odbiornik.

Przepływ wywoływany jest przez różnicę potencjałów.

Nadmierne jej narastanie czy to przez podwyższanie poziomu potencjału dostawców,

czy też obniżanie poziomu potencjału odbiorców jest niepożądane. Może prowadzić

do niekontrolowanego przepływu, który w większości przypadków jest niszczący dla

obsługiwanego systemu

[78]. Zatem system, którego istotnym elementem jest komunikacja, winien posiadać szybkie mechanizmy upustowe uruchomiane w sytuacja awaryjnych (w liniach wysokiego napięcia rolę taką

odgrywają odgromniki przepięciowe).

Niepożądanie wielki przepływ może też

być wynikiem wrogiej premedytacji. W systemach transmisji danych od niedawna

mnożą się destrukcyjne “zabawy” dywersantów sieciowych polegające na tym, że

przez łącza komunikacyjne bombardują oni wybrane porty systemowe różnych

serwerów wielką ilością pakietów, domagając się zupełnie zwyczajnej usługi,

świadczonej przez dany serwer. Aby utrudnić rozpoznanie ataku, dywersant

wykonuje go współbieżnie z kilku serwerów naraz, albo sekwencyjnie w krótkich

okresach czasu. Zaatakowany system, który został zalany zleceniami,

odmawia realizacji usług (ang. Denial of Service,

DoS)

[79]. Jeśli programowa inteligencja systemu nie zdoła rozpoznać natury przychodzącej informacji (a tak na ogół jest), to system komputera może ulec blokadzie. Skuteczność takiego ataku

uzależniona jest od liczby atakujących ofiarę serwerów. Szczególnie trudnym

aspektem tego typu dywersji jest to, że atakujący formalnie domaga się tylko tej

usługi, którą oficjalnie serwer ma świadczyć. To znaczy, że broniący się serwer

winien analizować od kogo zamówienie przyjmie, a od kogo nie! A zatem cenzura!

Ostatnio do powielania napastników skutecznie zaangażowano wirusy, co nie wróży

nic dobrego. Nawet od strony prawnej nie wiadomo, kogo tu ścigać. Sieć globalna

od długiego czasu ma anarchistyczny zapach i nie będzie chyba nic

zdumiewającego, jeśli wkrótce zacznie ona pękać na niewielkie sieci zaufania,

mające silną strukturę ścigania wykroczeń i bardzo kontrolowany ruch

międzysieciowy. Czyżby rzeczywiście czekał nas zmierzch

globalizacji?

Sensownym rozwiązaniem wydaje się przeniesienie obsługi

analizy i filtracji pakietów z serwerów na znane i używane od stosunkowo

długiego czasu urządzenia komunikacyjne typu ściana ogniowa (ang. Fire

Wall,

patrz Bezpieczeństwo Internetu, 1997, str. 318). Urządzenia takie są

jeszcze dalekie od doskonałości i ciągle drogie. Oczywiście dostępne są

również rozwiązania programowe, darmowe. W ogólności ściany ogniowe

występują w dwóch postaciach: jako urządzenie autonomiczne (izolowane

urządzenie komunikacyjne, DCE – patrz dalej) albo pakiet oprogramowania

do serwera lub dedykowanego komputera. Podstawowym problemem, który

ciągle pozostaje nie rozwiązany, jest niska ich przepustowość,

zwłaszcza przy szybkich sieciach. Aby zwiększyć ich skuteczność przy

obecnym charakterze transmisji należałoby wyposażać ściany ogniowe w

procesory mające 2-3 rzędy wielkości (100-1000 razy) większą

częstotliwość taktowania, niż ma sprzęt powszechnego użytku. Jest to

jednak nierealne, bo działało by wbrew polityce konkurencji na rynku

procesorów. Alternatywą dla takiego nierynkowego podejścia mogłoby być

wprowadzenie krótkich, dedykowanych, ale bardzo szybkich kanałów

ujemnego sprzężenia zwrotnego pomiędzy serwerem a najbliższą ścianą

ogniową. To wydaje się być obiecującą koncepcją, ale w dobie Internetu

optycznego do użytkownika końcowego i wprowadzenia pierwszych routerów

lambda i ta koncepcja wydaje się być rozwiązaniem nie budzącym nadziei.

Na myśl zatem przychodzi powrót do koncepcji architektury mainframe’ów;

a więc odwrót od osiedlowej (kampusowej) ściany ogniowej i

przeniesienia jej na wejście ważnego serwera w charakterze procesora

czołowego (ang. Front - End Processor ). Moduł taki powinien posiadać bardzo szybką logikę upustową

przekierowującą szkodliwe pakiety – czy nawet zainfekowaną długość fali na

urządzenie zerowe (ang. null - device).

Do tak zmienionej

architektury można zaproponować nową koncepcję polegającą na wprowadzeniu

globalnego, dedykowanego systemu lokalizacji węzłów wykrytych przestępstw

sieciowych. Ów system, sieciowy policjant, działał by w systemie automatycznym i

musiał by dysponować osobnymi, bardzo szybkimi i zdublowanymi optycznymi

kanałami transmisyjnymi, fizycznie oddzielonymi od systemu publicznego poprzez

dedykowany, “policyjny” moduł multipleksera optycznego, oraz wysokiej klasy

oprogramowaniem umożliwiającym blokadę zainfekowanych publicznych kanałów

optycznych na poziomie multipleksera optycznego. Zaprojektowanie i organizacja

takiego globalnego systemu powinna stać się pilnie przedmiotem uwagi na wysokich

szczeblach międzynarodowych.

W niniejszym rozdziale zajmiemy się

komunikacją w tym jej aspekcie, który jest ściśle związany z technologią

komputerową. Dwa czynniki legły u podstaw decyzji umieszczenia znacznej ilości

szczegółów technicznych w niniejszej części

książki.

Pierwszy to świadomość wysokiego poziomu kierowniczych kadr bibliotek amerykańskich w zakresie komunikacji, dobrze ilustrowany znakomitym wystąpieniem Ronalda Dienera, Dyrektora wykonawczego OHIONET na posiedzeniu komisji parlamentarnej poświęconym debacie nad nowelizacją Aktu Telekomunikacyjnego z roku 1981 (Diener [1981]).

Drugi to brak podobnego typu wystąpień bibliotekarzy polskich w tej samej tematyce.

To ostatnie zjawisko może być spowodowane ciągle jeszcze niedostatecznym opanowaniem technicznej nomenklatury, ale też być może i brakiem przekonania o skuteczności tego rodzaju działań. Jedno nie ulega wątpliwości: problemy bibliotekarzy muszą być rozwiązane przez bibliotekarzy i nikt inny za nich tego nie zrobi. Można przecież zapytać co przyjdzie Polsce z Katalogu Centralnego, jeżeli dostęp do niego przez sieć zarówno dla czytelnika, jak i bibliotekarza stanie się gehenną?

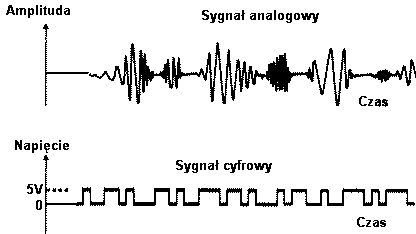

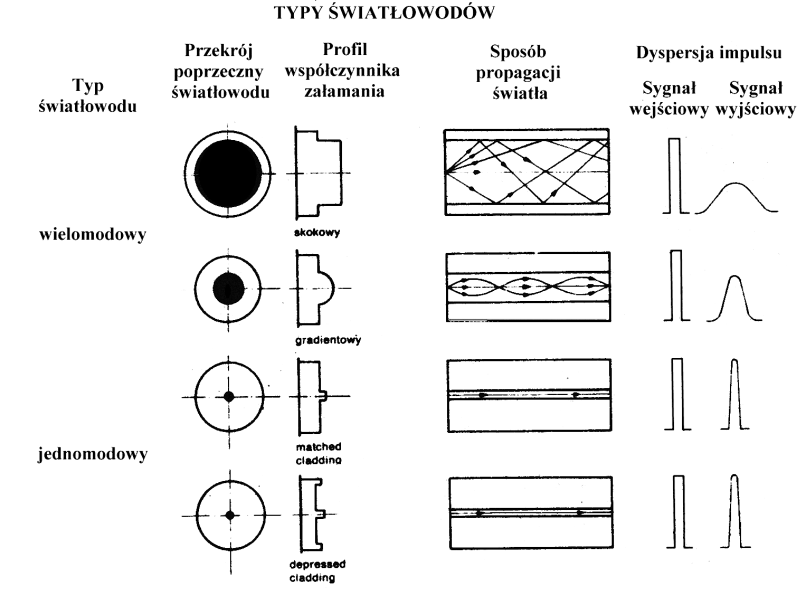

Człowiek od zarania swego stadnego życia starał się liczyć i przerabiać na liczby wszystko co tylko możliwe. W systemach transmisji danych towarem wędrującym od nadawcy do odbiorcy są ciągi cyfrowych obrazów analogowej rzeczywistości. Transmisję danych, ze zrozumiałych względów, modeluje się jednowymiarowo, a transmisje równoległe rozważa się jako agregację modeli jednowymiarowych.

Rysunek 48. Analogowa i cyfrowa transmisja sygnału.

Jak widać z powyższego w typowym sygnale analogowym

zmienia się na ogół zawsze zarówno amplituda, jak i częstotliwość. Fakt ten

ogromnie komplikuje wszelkiego rodzaju przetwarzanie takiego sygnału i tu leży

źródło szybkiego odchodzenia od przetwarzania analogowego do przetwarzania

cyfrowego.

W systemach komputerowych wyróżnia się dwa podstawowe typy

komunikujących się urządzeń:

urządzenie końcowe transmisji danych (ang. Data Terminal Equipment, DTE)

urządzenie komunikacyjne transmisji danych (ang. Data Communication Equipment, DCE)

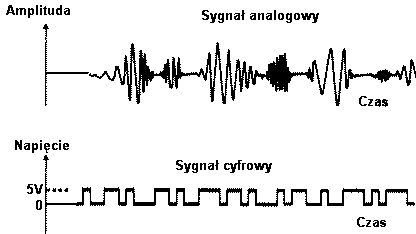

Urządzenia końcowe to: komputery, terminale znakowe, drukarki, plotery, skanery. Urządzenia komunikacyjne to na przykład modemy, routery, przełączniki. Odwołując się do schematu można powiedzieć, że urządzenie końcowe to prostokąt z doczepioną jedną kreską, a urządzenie komunikacyjne to prostokąt z doczepionymi dwoma lub więcej kreskami [80]:

Rysunek 49. Dwa typy urządzeń

transmisyjnych

|

|

Kreski doczepione do urządzeń na powyższym schemacie

oznaczają wydzielony kanał komunikacyjny. Zatem dostawcą jest

nadające DTE, a transmitowane dane poprzez jedno lub więcej DCE trafiają w końcu

do tego DTE, który jest odbiorcą. Jak widać z powyższego DCE wraz z

kanałami komunikacyjnymi grają rolę pośredników w procesie transmisji

danych (a jeśli pośrednik jest wynajętym usługodawcą, to nadawca musi

przewidzieć odpowiednie koszty w swoim budżecie).

Urządzenia końcowe to

przedmioty najbliższe użytkownikowi. To właśnie dla niego zostały stworzone.

Fakt ten jest więc dla niego wyzwaniem. Stworzony dla niego przedmiot został

wyposażony w różne lampki kontrolne, przełączniki/wyłączniki i gniazda w sposób

bogatszy, niż telewizor (doprecyzujmy od razu: telewizor analogowy). Do

końcowego użytkownika należy decyzja o tym, jakiego producenta preferuje,

dlaczego i jaki model wybrać. Zadanie to trudne i dla fachowców. Ale końcowy

użytkownik powinien czuć się zobowiązany do uczciwego partnerstwa, nie zaś

biernego wysłuchiwania swego eksperta. A potem, po zainstalowaniu i startowej

konfiguracji sprzętu winien ciągle ćwiczyć się w konfiguracji kupionego systemu.

Warto zatem poznać pewne niuanse, których znajomość pozwoli na oszczędzenie

niepotrzebnych problemów.

Zasilanie elektryczne DTE może stać się

obiektem różnych pokus. Współczesna technologia steruje wyraźnie w kierunku

redukcji okablowania. W zakresie urządzeń peryferyjnych (drukarki, skanery)

zaczyna się pojawiać tendencja do przeniesienia zasilania na kabel do transmisji

danych. Już w tej chwili można kupić skanery, które wymagają użycia tylko

jednego kabla USB i nie potrzebują ani osobnego zasilacza stałoprądowego, ani

kabla na 220V. Oczywiście takie skanery są mniej kłopotliwe w obsłudze,

zwłaszcza dla osób obciążonych inwalidztwem (np. niewidomych, dla których skaner

połączony z oprogramowaniem OCR należy do podstawowych narzędzi codziennej pracy

i nauki). Ale trzeba mieć na względzie, że taki dogodny w użytkowaniu zakup

okupimy:

Dawniej DTE obsługiwały tylko jeden interfejs

komunikacyjny. Jednak rozmaitość stosowanych standardów przemysłowych skłoniła

producentów do rozszerzenia oferty i znaczna liczba klasycznych urządzeń

końcowych takich jak komputery, drukarki, czy skanery posiada obecnie więcej niż

jeden port komunikacyjny. Tak więc np. skanery często posiadają port SCSI, USB a

nierzadko i LPT (drukarkowy, równoległy). Podobnie na karcie sieciowej Ethernet

typu COMBO możemy mieć nawet do trzech portów: RJ-45 (skrętka), BNC (kabel

współosiowy, koncentryk) oraz AUI (gniazdo rozszerzające np. do przyłączenia

transceiverów

[82] do obsługi łącz światłowodowych, lub innego gniazda AUI). Pozornie wydawało by się, że tak wyposażony sprzęt to typowe urządzenie komunikacyjne. Jednak nic z tego! Jeśli na przykład w karcie

sieciowej COMBO wykorzystamy port na skrętkę (RJ-45), to już nie będziemy mogli

korzystać z portu BNC. Oprogramowanie tych urządzeń nie przewiduje realizacji

funkcji pobierania informacji z jednego kanału i przesyłania jej na kanał drugi.

Jeśli ktoś połączył kablem USB swój skaner z komputerem to, przynajmniej

obecnie, nie będzie w stanie korzystać z drukarki, którą przyłączy do

dodatkowego portu LPT znajdującego się na skanerze. Drukarkę będzie musiał wpiąć

do portu LPT komputera, jakkolwiek taka decyzja była by trudna do rozwiązania

przestrzennego przy danym umeblowaniu.

Urządzenia końcowe mogą mieć

pewne, z zewnątrz niewidoczne, cechy. Patrząc na drukarkę każdy kojarzy ją sobie

z biernym odbiorem nadsyłanej do niej informacji i “przerabianiem” jej na postać

drukowaną. Mało kto domyśla się, że istnieją drukarki, które dla poprawnej pracy

wysyłają również zapytania do komunikującego się z nimi komputera. Drukarki

takie muszą być przyłączone przez kabel, który umożliwia dwukierunkową

transmisję. Użytkownik musi być przygotowany na to, że nie każdy kabel

“drukarkowy” będzie się do takiej drukarki nadawał, - z drugiej strony warto

mieć na uwadze fakt, że nie każda aplikacja będzie z tej dwukierunkowości

korzystać. Kabel, który doskonale nadaje się do jednej drukarki, wcale nie musi

nadawać się do innej; może też doskonale pracować pod starym DOS-em i nie

pracować w środowisku Windows.

Przechodząc do krótkiego omówienia

urządzeń komunikacyjnych (DCE) omówimy w charakterze przykładu ich najprostszego

i najczęściej występującego przedstawiciela: modem. Modem (skrót od:

MOdulator-DEModulator) jest urządzeniem, którego zadaniem jest takie

przekształcenie ciągu binarnych danych nadsyłanych przez urządzenie końcowe

(komputer, terminal, koncentrator terminali), aby możliwe było przesłanie ich

przez do drugiego podobnego systemu poprzez publiczne sieci telefoniczne ciągle

zdominowane przez technologię analogową. Modemy zaprojektowane są w taki sposób,

by skutecznie redukować wpływ różnych pasożytniczych procesów związanych z

transmisją sygnałów (zniekształcenia, zakłócenia, przesłuchy). Praktycznie

wszystkie współczesne modemy (może za wyjątkiem modemów optycznych) mają

zaimplementowane algorytmy korekty błędów i kompresji

danych.

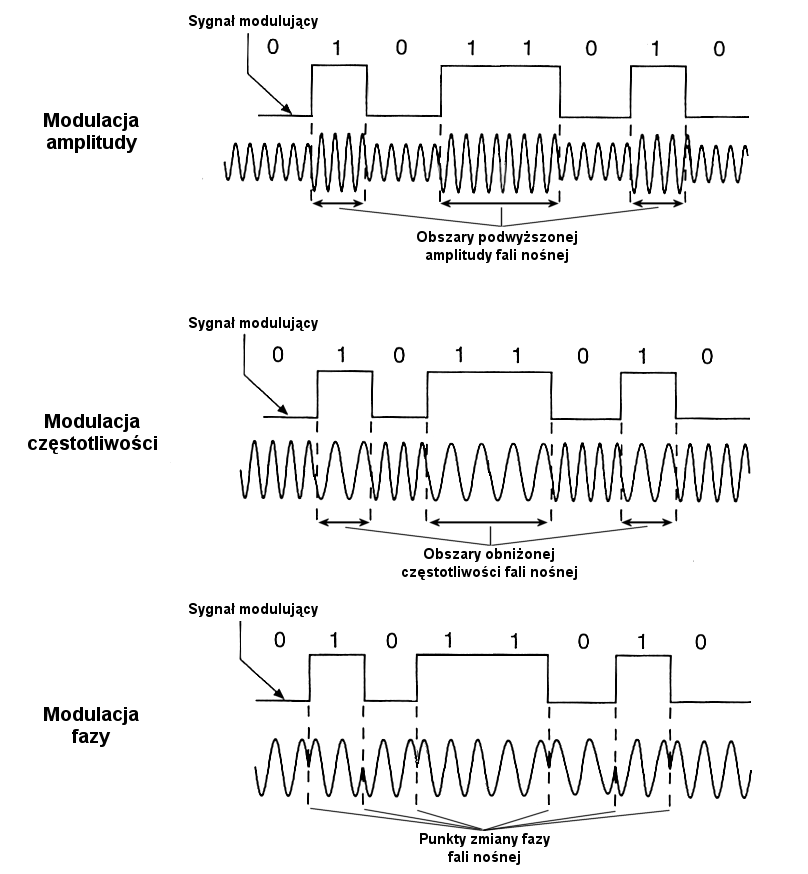

Rysunek 50. Typy modulacji fali nośnej w modemach

Modem generuje falę sinusoidalną, której częstotliwość jest „strawna” dla normalnych linii telefonicznych. Powyżej

przedstawione zostały graficznie trzy metody modulacji tej fali. Taka modulowana

fala jest odbierana przez zwykły aparat telefoniczny jako swego rodzaju trel

(świergot). Czytelnik zapewne już spostrzegł, że i w tym przypadku omawiane

urządzenia cyfrowe spełniające tą samą funkcje użytkową grupują się w trzech

rozłącznych klasach sprzętowych. Ta sytuacja naocznie pokazuje, jak ważnym

elementem jest techniczne dopasowanie komunikujących się ze sobą DCE (na

przykład modemu w domu z modemem zainstalowanym w pracy). Jest to kolejny

przykład polimorfizmu, tym razem odnoszący się do urządzeń sprzęgających systemy

cyfrowe.

Należy pamiętać, że DCE mogą (ale nie muszą) realizować

połączenie między dwoma różnymi środowiskami posługującymi się odrębnymi

protokołami, sposobem kodowania, sygnalizacją. W takim przypadku mówimy, że DCE

spełnia rolę bramki (inna nazwa: adapter międzysieciowy, ang. gateway)

rozdzielającej dwie sieci. Mówiąc obrazowo DCE to pudełko, które umożliwia

połączenie dwóch różnych rzeczywistości (z jednej strony może to być sieć

lokalna w standardzie Ethernet, z drugiej na przykład sieć ATM o zupełnie

inaczej rozmieszczonej informacji w ramach przesyłanych paczek). Nierzadko

zdarza się wszakże, że urządzenie komunikacyjne zawraca przesłaną do niego

informację do tego samego typu sieci, bez jej istotnej zmiany, co najwyżej po

wzmocnieniu sygnału (a czasem i regeneracji jego struktury). Urządzenie końcowe

transmisji danych (DTE) zwykle posiada się na własność. Urządzenia komunikacyjne

(DCE) można posiadać na własność (np. homologowany modem przy domowym

komputerze), lub dzierżawić od operatora sieci/dostawcy usług transmisji danych

(jak np. terminal ISDN dostarczany przez TPSA w ramach Stałego Dostępu do

Internetu, SDI).

Łączenie na własną rękę dwóch DCE pochodzących od

różnych producentów może czasem przysporzyć niemałych kłopotów – w tym również

ekonomicznych (Czermiński [2000:51], przypis 7). Wynika to z zamierzonego

ukrycia przez producentów pewnych technicznych cech, wyraźnie poprawiających

przepustowość DCE i dających urządzeniu przewagę nad produktami konkurencji.

Wykrycie ich jest możliwe tylko na drodze studiowania raportów z testów

współdziałania sprzętu pochodzącego od różnych producentów (ang.

interoperability tests). Zagadnienie to dobrze ilustrują wyniki testu modemów

wyprodukowanych przez 10 renomowanych firma amerykańskich. Modemy te formalnie

deklarowały spełnianie takich standardów jak V.22bis, V.32, V.32bis (szybkość),

V.42 bis, MNP 5 (kompresja), V.42, MNP 2,3 i 4 (kontrola błędów) i powinny

komunikować się między sobą bez najmniejszych problemów. Wypowiedź autora

artykułu opisującego test można odczytać jednoznacznie: Spędziliśmy tuziny

godzin przy testowaniu linii dalekiego dystansu, próbując określić, które

modemy mogą pracować ze sobą, ale tylko jeden mocny wniosek można było z tego

wyciągnąć - że jedynie Compsphere 3810 produkcji AT&T za 1595 USD był w

stanie pracować z każdym produktem w każdym czasie. [Derfler 1992]. Warto

nadmienić, że ceny testowanych modemów zaczynały się wówczas od 659 USD, ale ten

najlepszy modem był zdecydowanie najdroższy.

Należy wyrazić ubolewanie,

że problem ten został zupełnie niedoceniony przez projektantów Ustawy o

Zamówieniach Publicznych.

Pewien znaczący wyjątek w środowisku urządzeń

komunikacyjnych stanowią komputery, również te osobiste. Ze względu na istnienie

gniazd rozszerzających (ang. expansion slots) jest tu możliwość

instalacji dodatkowych urządzeń. W ten sposób łatwo przekształcić komputer z

urządzenia końcowego (DTE) w urządzenie komunikacyjne (DCE) o dość ogólnym

charakterze. Fakt ten został genialnie wykorzystany przez Phila Karna (

http://people.qualcomm.com/karn) do utworzenia pakietu realizującego protokół przeniesienia pakietów IP z sieci lokalnej w standardzie Ethernet na łącze szeregowe RS 232C. Protokół oznaczany

jest anagramem SLIP (ang. Serial Line Internet Protocol, SLIP) i

umożliwia tworzenia sieci internetowych poprzez łącza komutowane lub dedykowane.

Karn zastosował go do utworzenia Packet Radio, Internetu dla krótkofalowców

(KA9Q to jego kod wywoławczy). Jednym z celów tego projektu była redukcja

kosztów dostępu do usług sieciowych w środowisku krótkofalowców. Dostępny za

darmo poprzez serwery anonimowe FTP, pakiet KA9Q oprócz funkcji urządzenia

końcowego /terminala (DTE) mógł realizować funkcje routera IP (tzn. DCE), co w

pierwszych latach 90-tych było bezcenne dla niezamożnych instytucji pragnących

dołączyć się do Internetu (tak było np. w Polsce), lub pragnących zrealizować

niewielkie autonomiczne sieci IP w krajach obłożonych embargiem na zakup

zaawansowanej technologii. Po dzień dzisiejszy jest to ciągle popularna

technologia i np. w Wielkiej Brytanii istnieją publiczne numery dostępowe do

Internetu dla posiadaczy pakietu KA9Q zarówno w technologii analogowej, jak i

cyfrowej (ISDN). Phila Karne można bez większej przesady zaliczyć do

największych popularyzatorów światowego

Internetu.

Skojarzenie technik łączności z szeroko rozumianymi

technikami sterowania sformułowane zostało w pierwszych latach II Wojny

Światowej przez Wienera i Bigelowa, jeszcze bez formalnego powiązania z dopiero

rodzącymi się pierwszymi prototypami współczesnych komputerów [Wiener op.cit.:32]. Człowiek

komunikował się z nielicznymi maszynami przez powolne, elektromechaniczne

urządzenia dalekopisowe (ang. teletype). Pierwsze podejrzenie, że natura pracy

komputerów może mieć w przyszłości coś wspólnego z telekomunikacją, zawdzięczamy

amerykańskiej Federalnej Komisji ds. Komunikacji (FCC), która w trakcie dyskusji

natrafiła na trudności w precyzyjnym rozdzieleniu obydwu fenomenów na dwie

izolowane kategorie (Oxman [1999]). W związku z tym w 1966 r. Komisja zwróciła

się z otwartym zapytaniem, czy przypadkiem cele i polityka sformułowana w Akcie

Komunikacyjnym z 1934 r. nie byłyby lepiej spełnione, gdyby poddać usługi

komputerowe swobodnej grze rynkowej, zamiast wtłaczać je w ścisłe rygory Aktu

[Inquiry, 1966]. Zapytanie to rychło spotkało się z niezwykle żywym odzewem

zainteresowanych środowisk.

Współbieżnie z zainicjowaną przez FCC

dyskusją postępowały prace badawcze, które we wrześniu 1969 zostały uwieńczone

spektakularnym wynikiem: mała grupa inżynieryjna z firmy Bolt, Beranek i Newman

(BBN) zainstalowała na Uniwersytecie Kalifornijskim w Los Angeles prototypową

centralę komutacji pakietów (przełącznik), nazwaną Interface Message Processor

(IMP), a do końca tegoż roku jeszcze trzy takie przełączniki zostały

zainstalowane na trzech kolejnych uniwersytetach i połączone między sobą.

Istnienie sieci komputerowych stało się faktem.

Rozwijające się w

kolejnych miesiącach liczne dyskusje i mnożące się dezyderaty wskazywały na

społeczne oczekiwania szybszego dostosowania przepisów telekomunikacyjnych oraz

zmian opłat za usługi transmisyjne, stosownie do natury impulsowego charakteru

transmisji danych (ang. burst mode) pomiędzy systemami komputerowymi.

Wychodząc naprzeciw tym oczekiwaniom AT&T, ówczesny amerykański

telekomunikacyjny monopolista, już wtedy trzykrotnie (!) skrócił długość

minimalnej jednostki rozliczeniowej: z 3 min do 1 min. Trzydzieści lat później,

wiosną roku 2002 wyszukiwanie frazy „one second billing” poprzez Google daje

1510 indeksowanych dokumentów, podczas gdy Telekomunikacja Polska S.A. ciągle

utrzymuje 3-minutową jednostkę, na miarę najstarszego modelu, od którego

Amerykanie odeszli już w 1967 roku.

Po tej dosyć niemiłej dla biblitekarza porcji „kabelkologii” wypada odpowiedzieć na pytanie czemu miał służyć powyższy wywód. Otóż celem jego było ujawnienie pewnych dychotomii, które prowadzą do kolejnych niejednoznaczności środowiska cyfrowego. Nawet w standardach kabli i możliwych do nabycia adapterach konwertujących normatyw styku kryją się dychotomie. Odwołując się teraz do wcześniejszych komentarzy autora do artykułu Heima "Erotyczna ontologia cyberprzestrzeni" można by teraz rzec: „Rzeczywiście, w sieci funkcjonuje płeć. Mamy wszakże w kablach złączki żeńskie (gniazda) i meskie (wtyki)”. Tu jednak nie chodzi o sam fakt występowania dwóch uzupełniających się postaci. Trudność stanowi na pierwszy rzut oka niewidoczna dwuznaczność potencjalnego przeplotu. Dwa kable mogą mieć identyczny typ styku zewnętrznego, ale różnić się podlutowaniem przewodów (jak w null-modemie RS 232 skrzyżowane są przewody na nóżkach 2 i 3). Oczywiście rzecz trywialna do identyfikacji, ale wymaga trochę zachodu, no i wiedzy. System cyfrowy daje do dyspozycji zwykłego śmiertelnika pewne bogactwo, raj, a użytkownik już zjadł jabłko i musi się liczyć z konsekwencjami tego faktu. Czy możliwy jest odwrót? Praktyka ostatniego dziesięciolecia pokazuje, że pewne niejednoznaczności są eliminowane, ale inne się rodzą.

Model II (adresowy).

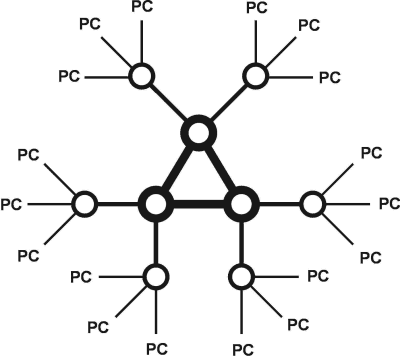

Komputery (oraz

inne urządzenia końcowe takie jak np. drukarki) włączone są w sztywną strukturę

połączeń fizycznych sieci komputerowej. Na sieć składają się węzły sieci

(węzły komunikacyjne - kółka) oraz kanały połączeniowe- kreski.

Węzłami na ogół są specjalizowane komputery wyposażone w procesor, pamięć, porty

komunikacyjne oraz oprogramowanie

[89] (Rysunek

53)

Rysunek 53. Schemat sieci komputerowej.

h

hWszystkie urządzenia końcowe sieci oraz węzły

sieciowe mają przyporządkowane adresy sieciowe, i na ogół zawsze też

nazwy mnemoniczne. Jeśli sieć ma zasięg globalny (np. Internet lub X.25

[90]), to adres każdego urządzenia końcowego (ale też podsieci) jest unikalny w skali światowej

[91].

Krótko zatrzymamy się przy Internecie. Ta dominująca obecnie na świecie sieć komputerowa ma swoje korzenie w amerykańskim wojskowym projekcie DARPA (Defence Advanced Research Projects

Agency). Jej pochodzenie sprawiło zatem, że żadne fazy tego projektu nie

przewidywały przyszłej obsługi całego świata. Założenia projektowe przewidywały

utworzenie adresu sieciowego składającego się z czterech bajtów oddzielonych

kropkami, razem 32 bity. Ta przestrzeń adresowa pozwala na zaadresowanie

232= 4 294 967 296 węzłów. Dla ułatwienia administracji, na potrzeby

powoływanych nowych sieci postanowiono wydzielić trzy klasy adresowe.

|

Typ sieci |

Część opisująca sieci |

Część opisująca hosty |

|

A |

1 - 126 |

0.0.1 - 255.255.254 |

|

B |

128.1 - 191.254 |

0.1 - 255.254 |

|

C |

192.0.1 - 223.255.254 |

1 - 254 |

Jak widać klasę A przyznaje

się w sytuacjach, w których zachodzi potrzeba adresowania ponad 16 mln hostów

[92]. Takich klas można przydzielić niewiele, bo 127. Za to pojedyncza taka klasa jest bardzo duża. Obecnie w tym obszarze adresowym panuje raczej pustka. Czytelnik zechce sobie sam wypróbować

ten obszar adresów przy pomocy funkcji ping i nslookup. W grudniu 2000 na ping

4.1.1.1 odpowiadał host w Wiedniu. Po zapytaniu nslookup 4.1.1.1 otrzymywało się

odpowiedź s5-0.vienna1-cr1.bbnplanet.net. Odpowiedź zdaje się

wskazywać, że adres IP=4.1.1.1 został przypisany portowi szeregowemu

[93] jakiegoś routera będącego własnością operatora sieciowego w Wiedniu. Egzaminując otoczenie tego adresu np. od 4.1.0.0 widzimy, że są tam najwyraźniej interfejsy

FDDI (zwyczajowo zaczynające się od litery f), i że jest to otoczenie

komunikacyjne wiedeńskiej sieci metropolitalnej. Przyznawanie adresów klasy A

operatorom sieciowym jest w pełni uzasadnione, ponieważ DCE bardzo szybko

wyczerpują zapas adresów.

Klas B można przydzielić znacznie więcej, bo

16 384 - choć oczywiście w skali całego świata jest to kropla w morzu potrzeb.

Ten właśnie typ sieci przydzielany był akademickim sieciom miejskim w Polsce. Na

potrzeby przyszłej Trójmiejskiej Akademickiej Sieci Komputerowej autor otrzymał

z Network Information Center klasę adresów 153.19.0.0, w ramach której można

zaadresować maksymalnie 65 536 hostów..

Klasa C przyznawana jest

organizacjom mniejszym, klas takich można przyznać 2 088 960, a w ramach każdej

klasy można zaadresować 255 hostów. W chwili obecnej jest to najczęściej

przyznawana klasa adresów..

W ramach przyznanej klasy administrator sieci

może manipulować przestrzenią adresową tworząc podsieci przy pomocy

maski. Maska jest 32-bitową liczbą z ustawionymi na 1 bitami w pozycjach

określających sieć i podsieć, oraz ustawionymi na 0 bitami w części opisującej

hosty. Tak np. maska 255.255.255.0 (klasyczna) oznacza, że administrator

zaplanował 256 podsieci, a w każdej będzie po 256 hostów. Jeżeli istnieje

konieczność zwiększenia liczby hostów, to może się to odbyć tylko kosztem

zmniejszenia liczby podsieci, przez odpowiednie podrasowanie maski. Ta rzecz

leży w wyłącznych kompetencjach administratora sieci i nie przysługuje końcowemu

użytkownikowi. Nawiasem mówiąc, odejście od klasycznej maski może przysporzyć

sporo kłopotów komunikacyjnych i nie jest rekomendowane..

Oprócz maski jest jeszcze jeden ważny adres sieciowy, który widnieje w opisie sieci każdego serwera i każdej stacji roboczej. Jest to adres bramki [94] (ang. gateway). Tu należy się pewne wyjaśnienie. Każdy pojedynczy port na najbliższym DCE, posiadającym zaimplementowany protokół IP (może to być router, czy mostek) ma przyporządkowany sobie osobny adres podsieci, która jest do niego przypisana. Dotyczy to w równym stopniu portu Ethernet, portu szeregowego, czy jakiegokolwiek innego portu komunikacyjnego. Cechą charakterystyczną tego adresu jest występowanie zera w części odnoszącej się do hostów. Adres ten jest wspólny dla wszystkich hostów rezydujących w danej podsieci i jest traktowany jako adres bramki. Przyjrzyjmy się, jak może to przykładowo wyglądać:

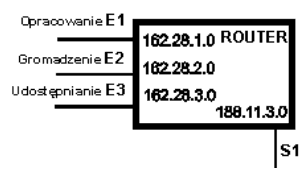

Rysunek 54. Podział sieci na podsieci w routerze

Jak widać, powyższy router,

jako typowe urządzenie komunikacyjne, ma kilka portów i każdemu przypisany jest

przez administratora adres osobnej podsieci. Porty routera mogą też mieć

przypisane adresy IP przydzielone przez administratora sieci nadrzędniej. Na

załączonym rysunku takim portem jest port szeregowy S1 (lokalne porty w

standardzie Ethernet oznaczone są literami E1 - E3). Niezależnie od tych

adresów, router sam jest komputerem i ma swój własny adres IP (ma też wbudowane

oprogramowanie i np. można się na niego zatelnetować). Adresy podsieci

przypisane poszczególnym portom Ethernetu są adresami bramek, "wyprowadzającymi"

te podsieci na świat (oczywiście 'świat IP').

Adres samego komputera

przyznaje administrator danej sieci, natomiast adres maski i bramki łatwo można

sobie zazwyczaj odpisać z metryczki sieciowej komputera sąsiada/sąsiadki jeśli

dotyczy to pobliskich stanowisk w pracy.:

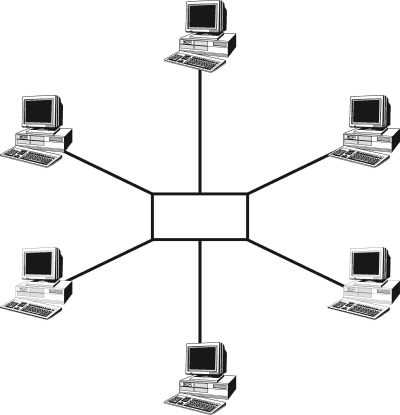

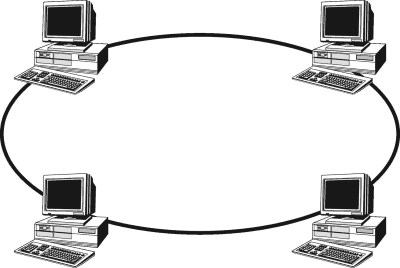

Magistrala uważana jest powszechnie za topologię

najmniej sprawną i wychodzącą z użycia. Dużą zaletą jej jest niższy koszt

inwestycyjny. Lepsze od niej są dwie pozostałe topologie (pętlowa i

gwiaździsta). Charakteryzują się one nadmiarowością strukturalną (redundancją) i

dzięki temu wykazują zauważalnie wyższą niezawodność; niestety ich podwyższona

jakość opłacona jest podwyższonymi kosztami przypadającymi na jedną stację

roboczą.

Świadomość przytoczonych faktów jest bardzo pomocna przy

planowaniu sieci na terenie budynków. Wrócimy tu ponownie do przewodniego w tej

książce pytania o istnienie dychotomii. Czy i w modelu adresowym (II) również

istnieją dychotomie? I tu odpowiedź jest, niestety, pozytywna. W zakresie

sprzętowym sprzęt komunikacyjny (DCE) taki jak huby i przełączniki jest

wyposażony w dodatkowe gniazdo na którym już jest zrealizowana funkcja przeplotu

(uplink). Zwykle jest ono geometrycznie odsunięte od pozostałych, ale jego styk

jest identyczny z gniazdkami bez zrealizowanego przeplotu. Zaniedbanie kontroli

tej cechy przez inżyniera odpowiedzialnego za zestawienie i wytestowanie sieci

na XXI Seminarium ELAG w Gdańsku (1997) spowodowało niemiłe zamieszanie

organizacyjne i konieczność reorganizacji kolejności wystąpień uczestników

podczas pierwszego dnia

konferencji.

Na wstępie wyjaśnijmy sobie w sposób popularny, co

możemy nazwać siecią komputerową. Otóż za sieć komputerową możemy uważać zbiór

autonomicznych komputerów wyposażonych w oprogramowanie komunikacyjne i

użytkowe (aplikacyjne) wraz z technicznymi środkami pozwalającymi na ich

wzajemną łączność.

Przyjmijmy z kolei

pewną klasyfikację zasięgu sieci. Przyjęło się, że to, co obejmuje całą kulę

ziemską nazywa się siecią globalną. Składają się nań sieci narodowe i

ponadnarodowe — organizacyjne, korporacyjne (np. sieci firm Hewlett-Packard,

IBM, Sun, Cisco etc). Wszystkie te sieci należą do klasy sieci rozległych (WAN —

ang. Wide Area Network).

Przyglądając się sieci krajowej z bliższej odległości, dojrzymy pewne

aglomeracje miejskie połączone kreskami. To, co ukaże nam w powiększeniu system

konkretnej aglomeracji to sieć metropolitalna (MAN — ang. Metropolitan Area

Network): ujrzymy nitki łączące osiedla (kampusy). Te ostatnie wzięte pod

mikroskop ujawnią już pojedyncze komputery, drukarki sieciowe i inne urządzenia

połączone między sobą w segmenty sieci lokalnych (LAN — ang. Local Area Network). W obszarze

wewnątrz instytucjonalnym buduje się miniaturowe sieci, naogół oparte o Model 1

(bezadresowy) i służące do integracji sprzętowej systemu komputerowego. Te noszą

skrótową nazwę SAN (ang. Storage Area

Network).

Jak widać z powyższego opis sieci

musi uwzględniać zarówno odesłanie do komunikujących się komputerów jak i

środowiska komunikacyjnego. Na potrzeby takiego opisu stworzono warstwowe modele

systemów.

Historycznie pierwszy opis uproszczonego, czterowarstwowego modelu został opracowany w USA w ramach projektu ARPA. W dwóch systemach, między którymi ma zachodzić wymiana informacji, wyróżniano wg filozofii tego projektu, cztery warstwy:

Rysunek 58. Model

ARPA. Wizualizacja w postaci tabeli.

|

Warstwa Aplikacji |

Warstwa aplikacji | |

|

Warstwa transportowa |

Warstwa transportowa | |

|

Warstwa międzysieciowa (Internet) |

← Protokół → |

Warstwa międzysieciowa (Internet) |

|

Warstwa fizyczna |

Warstwa fizyczna |

System 1 System 2

Przenoszenie

informacji pomiędzy dwoma sąsiednimi warstwami tego samego systemu (pionowe)

nazwano usługą, natomiast przenoszenie informacji pomiędzy dwoma systemami na

poziomie tej samej warstwy (poziome) - protokołem.

Późniejsze prace

normalizacyjne doprowadziły do podwyższenia stopnia szczegółowości opisu. W

rygorystycznych zamierzeniach autorów normy ISO 7498 (ISO[1]). spomiędzy warstw

modelu ARPA postanowiono wydzielić dodatkowe warstwy, rozszerzając model do 7

warstw:

struktura informacji

|

Warstwa aplikacji |

Warstwa aplikacji |

Wiadomość | |

|

Warstwa prezentacji |

Warstwa prezentacji |

Wiadomość | |

|

Warstwa sesji |

Warstwa sesji |

Wiadomość | |

|

Warstwa transportowa |

Warstwa transportowa |

Wiadomość | |

|

Warstwa sieciowa |

Warstwa sieciowa |

Pakiet | |

|

Warstwa łącza danych |

Warstwa łącza danych |

Ramka | |

|

Warstwa fizyczna |

Warstwa fizyczna |

Bit |

Rysunek 59. Model ISO/OSI. Struktura informacji na poszczególnych warstwach modelu

Pierwsze trzy warstwy

(fizyczna, łącza danych i sieciowa) stanowią podsystem komunikacyjny, cztery

następne (transportowa -> aplikacji) - są zorientowane na obsługę

użytkownika.

Odrywając się myślowo od ciągu bitów, czy sekwencji ramek

czytelnik zechce zabawić się teraz budując sobie intelektualny model

organizacyjny komunikacji dwóch bardzo odmiennych bibliotek (np. swojej polskiej

oraz jakiejś japońskiej). Opisane wyżej role poszczególnych warstw modelu

systemów otwartych mogą grać fizyczne osoby zatrudnione w bibliotece osoby

modelującej współpracę.

.

Tworzona sieć nie musi implementować wszystkich

warstw modelu ISO/OSI. Jeśli jest to sieć lokalna (LAN), nie przyłączona do

sieci rozległej (WAN) - to nie musi ona uwzględniać faktu istnienia gdzieś na

świecie innych sieci tego samego typu. Wtedy z pewnością model musi

implementować pierwszą warstwę (fizyczną) - bo przecież komputery muszą jakoś

być fizycznie połączone, natomiast nie ma potrzeby implementować wszystkich

funkcji warstwy trzeciej (sieciowej). W szczególności nie jest potrzebny cały

mechanizm adresowania wymagany w sieciach rozległych. Natomiast konieczna jest

adresacja lokalna (adres fizyczny, zwany też adresem sprzętowym). Prostym

przykładem takiej sieci są trzy komputery wyposażone w karty sieciowe standardu

Ethernet 10 Base 2 i jedna drukarka sieciowa, połączone między sobą kablem

koncentrycznym, zakończonym 50 Ω terminatorami. Taki system nie musi

implementować szyfrowania, konwersji repertuaru znaków i innych funkcji warstwy

prezentacji, nie ma potrzeby prowadzenia taryfikacji i zestawiania raportów z

warstwy sieciowej itp. Prosty system jest tani, ale jego możliwości są

niewielkie.

Jeżeli pewien obszar ma być

wykorzystywany przez różnych użytkowników, to zwykle wprowadza się na nim jakąś

formę administracji. Najprostszą taką formą administracji jest sterowanie

asynchroniczne. W charakterze przykładu można podać czasowe wprowadzenie

dwukierunkowego ruchu pojazdów na jednym pasie jezdni, w związku prowadzonymi

robotami drogowymi na drugim pasie. Stojący na poboczu jezdni policjant

rozstrzyga, w którym kierunku w danym momencie będą jechały pojazdy, sugerując

się intensywnością ruchu w danym kierunku. Taka metoda jest dobra jako doraźne

rozwiązanie na krótki okres czasu. Podobnie funkcjonują mało uczęszczane

przejścia dla pieszych wyposażone w światła, których zapalenie inicjowane jest

przez oczekującego na przejście przechodnia.

Współdzielenie pewnego

obszaru nadzorowane przez prostą automatykę dobrze ilustruje funkcjonowanie

świateł na skrzyżowaniu jezdni. Na znakomitej większości takich miejsc w Polsce,

w cyklu dziennym iloraz długości interwału czasowego otwarcia jednej osi przez

długość interwału czasowego otwarcia drugiej osi jest stały, bez względu na

intensywność faktycznego ruchu pojazdów. To najprostszy sposób współdzielenia

obszaru skrzyżowania przez przydział czasu dostępu.

Jeszcze podczas

projektowania starych, analogowych systemów transmisji poczyniono spostrzeżenie

znane ze wszystkich starych inżynierii, takich jak dostawy wody, czy prądu

elektrycznego, że w systemach masowej obsługi zawsze należy mieć na względzie

fakt, iż w tej samej chwili nie wszyscy uprawnieni do korzystania użytkownicy

będą chcieli być obsłużeni. Wynika to z faktu, że wykorzystanie systemu przez

użytkownika ma charakter losowy i prawdopodobieństwo zdarzenia polegającego na

tym, że naraz wszyscy użytkownicy kategorycznie zechcą z skorzystać z systemu,

jest niewielkie. Mało tego. Jest ono tym mniejsze, im bardziej zróżnicowane jest

zawodowo środowisko użytkowników, a statystycznie działa ten schemat tym lepiej,

im jest ono liczniejsze. Współdzielenie medium transmisyjnego w klasycznej

telekomunikacji realizowano zazwyczaj przez zwielokrotnienie

(multipleksację). Przyjrzyjmy się jak można realizować asynchroniczny dostęp

czterech różnych użytkowników do jednego serwera.

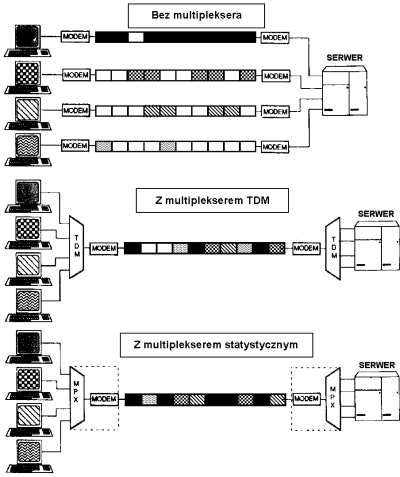

Rysunek 60. Modemy i

multipleksery

Schemat powyższy jest

oczywiście schematem bardzo uproszczonym. Natura asynchronicznego dostępu

powoduje na ogół znaczny stopień niewykorzystania możliwości transmisyjnych

kanału komunikacyjnego. Wprowadzenie multiplekserów zmniejsza dramatycznie

liczbę używanych modemów, liczbę kanałów transmisyjnych (np. liniii

telefonicznych). Jednak klasyczne zwielokrotnienie z podziałem czasu (ang.

Time Division Multiplexing, TDM) było rozwiązaniem niezbyt ekonomicznym.

Jeśli przez pewien czas któryś z nadajników nie transmitował, to rygorystyczne

przydzielanie mu w określonym momencie czasowym dostępu do medium transmisyjnego

prowadziło w efekcie do przerw w transmisj. Znaczną poprawą stało się tu

wprowadzenie multiplekserów statystycznych, których algorytmy przydziału dostępu

do medium oparte są na analizie ruchu w kanałach wejściowych. Oprócz

zwielokrotnienia z podziałem czasu w powszechnym użyciu jest również

zwielokrotnienie z podziałem częstotliwości (ang. Frequency Division

Multiplexing, FDM), przeżywające obecnie burzliwy renesans w swej optycznej

odmianie jako (D)WDM (zwielokrotnienie falowe, ang. (Dense) Wavenlength Division Multiplexing).

Wreszcie warto wspomnieć o zwielokrotnieniu z podziałem kodu CDM (ang.

Code Division Multiplexing) – to ostatnie odnoszące się do wszystkich

kanałów równocześnie – zatem mogące mieć charakter dyskryminujący dla

określonych kanałów (osób, firm, państw). Wspominamy tutaj te technologie, aby

przybliżyć Czytelnikowi problematykę współdzielenia medium w sieciach

komputerowych. Problem ten jest niezmiernie ważny, bo niedocenienie go

doprowadziło do załamania poufności danych przesyłanych w sieciach

komputerowych. Wymieniona wyżej sieć lokalna w topologii "magistrala" (np.

"cienki LAN"), to klasyczny przypadek współdzielenia medium: długi (na ogół)

kabel koncentryczny do którego wpięte są adaptery sieciowe poszczególnych stacji

roboczych. Pakiety nadawane przez jedną ze stacji roboczych wędrują wzdłuż

kabla, zazwyczaj "odbijając" się od tych adapterów sieciowych, do których nie są

adresowane. Niestety, już dawno spostrzeżono, że nie jest trudno być pasywnym

"słuchaczem" tego co się dzieje w kablu. Tak powstał sniffing -

obwąchiwanie medium. Ponieważ budowa pakietów jest znana od zarania sieci, to

intruzowi nie było zbyt trudno odczytać zawartość pakietów transmitowanych

"jawnym tekstem", tj. bez szyfrowania. Głównym źródłem informacji, na które

sieciowy intruz zastawiał sidła, były hasła użytkowników transmitowane w czasie

otwierania zdalnych sesji przy pomocy popularnego pakietu telnet. Przejęcie

kontroli nad cudzym kontem było pierwszym krokiem do inwazji na słaby system

i/lub słabego administratora systemu. Tego rodzaju destrukcyjna działalność

sieciowa doprowadziła do zmian w projektowaniu sieci. Nowym, choć nieco droższym

standardem stały się sieci o topologii gwiazdy. Ale nie każda sieć tego typu

daje gwarancję immunologicznej transmisji. Jeśli węzłem takiej sieci jest prosty

hub/koncentrator, to spełnia on zaledwie usługę regeneracji sygnału (praktycznie

implementuje tylko pierwszą, fizyczną warstwę modelu ISO/OSI), bez możliwości

separacji przestrzeni adresowej. Dopiero zakup droższego przełącznika

sieci lokalnej, implementującego trzy dolne warstwy modelu ISO/OSI, daje szansę

przypisania osobnej podsieci każdej stacji roboczej. Taka sytuacja jest

rozwiązaniem lokalnym i jeszcze nie daje pełnego bezpieczeństwa. Odtąd wszystko

zależy od tego co się dzieje w dalszej części sieci - za przełącznikiem. Z

pewnością oprócz stworzenia bezpiecznej konfiguracji sieci po stronie klienta,

potrzebna jest jeszcze bezpieczna konfiguracja po stronie serwera. Oprócz

wymienionego problemu separacji medium transmisyjnego na poziomie lokalnym

dochodzi sprawa szyfrowania. Już zamiana popularnego telnetu na pakiet

ssh (ang. Secure Shell) znacznie zabezpieczy interesy

komunikujących się po sieci stron. Niestety, skuteczność obrony przed intruzami

zależy od powszechnego wdrożenia zabezpieczeń - zarówno po stronie serwerów, jak

i klientów. Problem ten jest ciągle aktualny i nie należy przypuszczać, by

szybko zmalał do poziomu marginalnego.

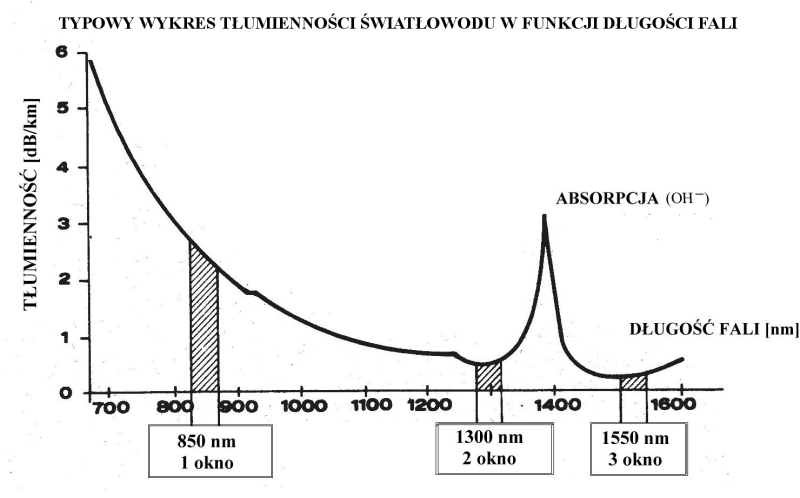

Powstaje pytanie, czy w dobie

Internetu Optycznego, gdy Komitet Badań Naukowych podjął pierwsze decyzje

dotyczące finansowania projektu PIONIER zachodzi niebezpieczeństwo przechwytu

transmitowanych pakietów informacji? Czy poziom technologiczny, na jakim

realizowana jest transmisja i (ewentualnie) routing optyczny dopuszcza, lub

potencjalnie może dopuszczać, interwencję intruza? Są poważne obawy by sądzić,

że odpowiedź na to pytanie jest pozytywna. Wprowadzone przez Afrika Korps

telefony na podczerwień zapewniały w czasie kampanii praktycznie 100% poufność.

Tym razem nie jest aż tak dobrze. W obecnie stosowanej technice multipleksacji

różnych długości fali w jednym światłowodzie w wersji standardowej (WDM) lub

gęstej (DWDM), z konieczności realizowane jest bliskie położenie emitowanych

przez lasery długości fal. Ale impulsy emitowane przez lasery nie są

prostokątne, tylko mają charakterystykę gaussowską - zatem pomiędzy wiązkami

występuje przesłuch. Firma Radiant Research podaje [Radiant, 2000], że

produkowane przez nich multipleksery/demultipleksery dla podanych czterech

długości fal zlokalizowanych w trzecim okienku optycznym (1512, 1532, 1552 oraz

1572 nm) mają przesłuch między kanałami nie większy niż 40 dB. To może jest

dobra wartość dla amatorów, ale nie dla zawodowców i podobnie jak w przypadku

współdzielenia medium w innych technologiach jest być może tylko kwestią czasu,

kto i kiedy sięgnie po cudze informacje w technice WDM. Przyszłość pokaże, czy

dla wszystkich znanych przypadków współdzielenia medium da się zastosować znane

sarkastyczne powiedzenie, że z rodziną najlepiej wychodzi się na zdjęciu.

Współużytkowanie medium transmisyjnego to kolejny objaw polimorfizmu środowiska

cyfrowego. Dziś wiemy już, że natura tego polimorfizmu z jednej strony została

mądrze wykorzystana do zwielokrotnienia stopnia wykorzystania sprzętu

oraz medium transmisyjnego – to tak jak wprowadzenie pracy wielozmianowej pozwalającej w

ciągu doby na tych samych maszynach więcej wyprodukować i dać ludziom więcej

zarobić. Z drugiej jednak strony ten sam polimorfizm został niecnie wykorzystany

zarówno przez różne państwowe agencje zajmujące się inwigilacją, jak i szerokie

spektrum siedciowych przestępców i wandali.

Jak widać z powyższego,

również technologia transmisyjna uwidacznia swój polimorfizm – co gorsza jest to

polimorfizm kaskadowy. Jeśli ograniczyć się do przekazu wykorzystującego

promieniowanie elektromagnetyczne, to ze względów fizycznych podstawowym

podziałem jest podział częstotliwościowy – wynika to z różnic w naturze

nadajników i odbiorników. Na drugim poziomie może następować podział przestrzeni

transmisyjnej względem czasu, lub względem kodu – ale również względem

częstotliwości (podział pasma na podpasma). Już w tym miejscu uwidaczniają się

mechanizmy rekurencyjne w zwielokrotnieniu dostępu do medium

transmisyjnego.

[78]Przykłady katastrofalnych skutków narastającego napięcia znamy z przyrody (wyładowania atmosferyczne, naprężenia skorupy ziemskiej) czy historii (rewolucje, niszczenie cywilizacji przez

prymitywne ludy poszukujące środków do życia). Również zamierzone, ale

niedostatecznie kontrolowane przepływy są groźne dla systemów z wewnętrzną

różnicą potencjałów. Weźmy za przykład ogniwo galwaniczne (bateryjkę

kieszonkową, akumulator). Krótkie zwarcie biegunów grubym drutem miedzianym

ogniwa manifestuje się gwałtownym przepływem prądu, a wydzielone na drucie

ciepło może go nawet stopić. Przy okazji zniszczeniu, lub bardzo poważnemu

uszkodzeniu, ulega wewnętrzna struktura ogniwa. Wiedzą o tym kierowcy samochodów

mający problemy z rozruchem silnika i po kilku nieudanych próbach dają

akumulatorowi “odpocząć”.

Zbliżonej klasy problem dotyczy tego, co możemy nazwać impulsowym przeciążeniem licencyjnym. Zilustrujemy to na przykładzie biblioteki akademickiej, która po całkowitej automatyzacji wszystkich podległych jej jednostek organizacyjnych będzie regularnie cierpieć na impulsowe przeciążenia systemu w okresach przerw w zajęciach (10-15 minut w ciągu godziny) i znacznie mniejsze poza tym okresem, jeśli tylko przyjąć istnienie szybkiego i dobrego mechanizmu “sprzątania” wiszących sesji. Do rozwiązania tego problemu nie musi się od razu rozszerzać bardzo kosztownej licencji na większą liczbę równoczesnych użytkowników aplikacji. Wystarczy po prostu wprowadzić odpowiednie zmiany organizacyjne. Jednakże do przygotowania takiego projektu należy najpierw zatrudnić analityka systemowego, któremu zleci się zbadanie długo- i krótkoterminowych profilów obciążenia systemu, oraz zaproponowanie odpowiednich zmian. Chyba nie będzie tu zaskakujące twierdzenie, że taka praktyka analityczna należy w bibliotekach do rzadkości.

[79]Wymuszenie odmowy usługi poprzez atak z kilku rozproszonych serwerów opisane jest w literaturze skrótem DDoS (ang. Distributed Denial of Service). Ciekawy artykuł na ten temat opublikował ostatnio Czarnowski [2000].

[80] Oczywiście sformułowanie tego typu jest uproszczeniem. Większość współczesnych systemów operacyjnych zezwala użytkownikowi na wielowątkowość realizowanych zadań. W szczególności użytkownik może zlecić systemowi drukowanie długiego dokumentu “w tle” i otworzyć sesję skanowania. Oznacza to (przy jednym procesorze) przemienność czasową zlecania zadań drukarce i skanerowi, chociaż na pierwszy rzut oka obydwa urządzenia będą pracowały współbieżnie. Możemy powiedzieć, że taka praca to swego rodzaju zastosowanie technologii multipleksacji z podziałem czasu (ang, Time Division Multiplexing, TDM - patrz współdzielenie pasma transmisyjnego) w stosunku do obciążania komputerowego procesora.

[81] Przy okazji dodamy, że należy zdecydowanie unikać wkładania złoconego wtyku w niezłocone gniazdo i vice versa, ponieważ prowadzi to do szybkiego uruchomienia korozji elektrochemicznej niezłoconej powierzchni, a w następstwie tego do pogorszenia jakości styku aż do zaniku przewodnictwa włącznie.

[82] ang.: Transceiver =Transmitter + Receiver (nadajnik zintegrowany z odbiornikiem linii).

[83] Z uwagi na straty w czasie transmisji sygnał przesyłany przez kable oceaniczne wymaga znacznego wzmocnienia. Zwykle robi się to poprzez wzmocnienie optyczne transmitowanego sygnału (rolę wzmacniacza odgrywa domieszka jonów erbu w szkle, pobudzana promieniowaniem lasera wysokiej mocy poprzez osobne wydzielone włókno światłowodowe). Najdłuższa zbudowana obecnie światłowodowa linia przesyłowa łączy Australię i Nową Zelandię z zachodnim wybrzeżem USA (California) i ma długość 35 tys. km. przy przepływności binarnej 120 Gbps.

[84] Nie jest to określenie ścisłe. W gruncie rzeczy chodzi tu o adresowanie sprzętowe (np. zworki) i programowe.

[85] Długość kabla waha się od 10 m. dla RS232 bez dodatkowych urządzeń takich jak pętla prądowa, do 72 m. dla IEEE 1394. Dla interfejsu SCSI-2 firma Hewlett-Packard opracowała światłowodowy przedłużacz (Fiber-optic SCSI extender 28643A) dostarczany w odcinkach długości 50 i 100 m. Komunikacja w paśmie podczerwieni (interfejs IrDA - skrót od ang. Infrared Data Association) ma zasięg ograniczony do 20 m w przypadku promieniowania rozproszonego (odbicie od sufitu, podłogi i ścian) oraz 500 m dla wiązki skupionej [Zieliński,2000:44].

[86] Bardzo obecnie popularny interfejs USB (ang. Universal Serial Bus – Uniwersalna Szyna Szeregowa), jest w nieprzyjemny sposób powiązany na poziomie obecnej definicji standardu z magistralą AGP, zaprojektowaną do obsługi kart video. Próba połączenia poprzez kabel USB skanera z komputerem, na którym dla oszczędności zamiast karty graficznej na magistralę AGP zainstalowano kartę graficzną na magistralę PCI może spowodować nierozpoznanie skanera przez system operacyjny komputera.

[87] Filozofia null-modemu polega na fizycznym połączeniu przewodem wyjścia nadajnika (Tx) interfejsu komunikacyjnego jednego komputera z wejściem odbiornika interfejsu komunikacyjnego (Rx) drugiego komputera i vice versa, oraz uwspólnieniu masy (Gnd) obydwu systemów. Dla portów RS 232 null-modem realizuje się na 3 przewodach łączących porty jak następuje:

Nr nóżki gniazda 1 Nr nóżki gniazda 2[88] Mimo formalnie bezadresowego systemu transmisji poszczególne urządzenia mogą być zaadresowane sprzętowo, np. przy pomocy zworek (popularne rozwiązanie w systemie SCSI), lub ustawień konfiguracyjnych na poziomie setupu. Jednak w takich przypadkach adres nie ma charakteru globalnego i nie podlega żadnej zewnętrznej administracji.

[89] Jako przykład sprzętu zaprojektowanego do pełnienia roli węzła wieloprotokołowych sieci komputerowych wymienimy bardzo ceniony na początku lat 90-tych router AGS+ firmy Cisco Systems Inc. Sprzęt ten jest wyposażony w procesor Motorola 68020 taktowany zegarem 30 MHz, niewielką pamięć ROM (1 MB), RAM (4 MB) oraz 64 KB nieulotnej pamięci reprogramowalnej elektrycznie (EEPROM). Router ten nie posiada jednak klawiatury, karty graficznej ani monitora, za to ma dużo gniazd rozszerzających na pomieszczenie różnego typu kart komunikacyjnych - na pierwszy rzut oka nie przypomina zatem żadnego popularnego komputera. Można go konfigurować poprzez terminal włączony w port konsoli operatorskiej (RS 232) lub z sieci.

Węzeł sieci jednak nie musi być specjalizowanym sprzętem. Również komputer osobisty (PC) bez większych kosztów może być przekształcony w węzeł sieci Internet poprzez wyposażenie go w kartę sieciową oraz dostępne na sieci darmowe oprogramowanie KA9Q pozwalające przekierować ruch pakietów z segmentu LANu na port szeregowy PC, a stąd przez modem do dowolnego innego miejsca obsługującego protokoł SLIP.

[90] X.25 jest protokołem sieci rozległych opracowany przez CCITT, pozwalającym na dobrą transmisję przy złym okablowaniu miedzianym o dużej stratności. Jest on sukcesywnie wypierany przez nowsze technologie (Frame Relay, ATM). W roku 2000 tylko nieliczne biblioteki na świecie (jak np. OCLC, ICCU) jeszcze korzystały z tej technologii – ale tylko jako uzupełniającej w stosunku do Internetu (kontrolowany dostęp dla bibliotekarzy katalogujących). Czynnikiem zniechęcającym klientów do tej sieci jest mętny system billingowy przy wysokich kosztach eksploatacji. Syntetyczne omówienie tej sieci można znaleźć w pracy Wiśniewskiego (1996)

[91] Twórcy Internetu nie przewidzieli skali przyszłego rozwoju technologicznego w zakresie masowej produkcji komputerów osobistych i usprawnienia komunikacji. Już w połowie lat dziewięćdziesiątych stało się jasne, że zapas unikalnych adresów internetowych gwałtownie maleje i istnieje pilna potrzeba opracowania nowego modelu adresacji globalnej. Nowy model winien być taki, by z jednej strony pozwalał na łatwą inkorporację obecnie funkcjonującego schematu adresowania, z drugiej zaś – by nowa pula adresów nie uległą wyczerpaniu w jakimś zauważalnym czasie.

[92] Hostem na ogół jest komputer, ale także inne DTE (drukarka sieciowa) lub DCE (np. router).

[93] Porównaj dalej opis bramki (ang. gateway)

[94] Czasami jest ona nazywana śluzą (Buchanan w tłumaczeniu Jarmakiewicza i Krygiera [1997]:197)