Motto:

Ważną własnością systemów jest ich zdolność do odpowiedzi na zmiany, do dostosowania samych siebie do swego otoczenia i zapewnienia sobie stabilności, wystarczającej do przetrwania. Cechy usług bibliotecznych zdają się zaprzeczać tej własności. Upatruje się w nich niemoc do adaptacji i słabą stabilność. Oddźwięk na wszystko, co zdarza się w bibliotece, jest ogólnie mówiąc, lichy, niekompletny, lub wogóle go nie ma; cele usług bibliotecznych są mgliste; same usługi są często krytykowane za brak reakcji, a bibliotekarze - za brak kontroli nad otoczeniem.Michael K. Buckland, “Library Services in Theory and Context”, 1988, strona 28.

Zgodnie z przyjętą w tej

książce linią prezentacji, pojęcie systemu będzie ograniczone do tych elementów

budowy systemu cyfrowego, których znajomość może się okazać pożyteczna dla

bibliotekarzy zarówno w pracy codziennej, jak i w planowaniu zachowań

strategicznych.

Środowisko cyfrowe systemu nowoczesnej biblioteki,

podobnie jak i innych instytucji pełniących służbę publiczną, jest - czy to nam

się podoba, czy nie, komputero-centryczne. Wokół komputera organizowane jest

pewne otoczenie sprzętowo – programowe, pozwalające na komunikację między

człowiekiem i maszyną [Zorkoczy, Heap 1995]. Bogactwo czy ubóstwo takiego

systemu zależy z pewnością od pieniędzy, ale chyba w jeszcze większej mierze od

wykształcenia i organizacyjnych umiejętności jego zarządców. Obecne wyposażenie

bibliotek jest w tej materii nad wyraz skromne i tylko najbogatsze z nich będą

mogły zdobyć się na niektóre z urządzeń opisanych poniżej. Jak dotąd do

najdroższych elementów systemu należą duże firmowe serwery, szybkie sieciowe

systemy archiwizacyjne dużej pojemności oraz praktycznie całe oprogramowanie.

Tylko rozwiązania o charakterze konsorcjum dają szansę mniejszym bibliotekom na

podjęcie pracy w nowoczesnych, bezpiecznych systemach. Na szczęście świadomość

wagi tego problemu stała się w Polsce wystarczająco powszechna, by zapewnić

stabilność na poziomie regionalnym. Ciągle pozostaje problemem integracja

techniczna różnych platform i harmonizacja prac na poziomie międzysystemowym.

Ale przełamanie tego impasu jest zapewne kwestią niedługiego już

czasu.

Na całość systemu składają zasoby ludzkie, sprzętowe, programowe

oraz wszelkiego rodzaju dane. Zasobem systemu jest każdy jego element, który

może być przydzielony określonej części systemu lub programowi użytkowemu

[Iszkowski et al. 1987 strona 16]. Zasobami systemu cyfrowego (ang. system

resources) zarządza system operacyjny. W niniejszym rozdziale postaramy się

omówić ważniejsze aspekty, związane z funkcjonowaniem systemów cyfrowych w

organizacyjnym otoczeniu bibliotek.

System cyfrowy zawsze może

korzystać z zasobów własnych, ale w określonych sytuacjach może być również

autoryzowany do korzystania z zasobów innych systemów. Zasoby dzielimy na

sprzętowe (komputery, urządzenia peryferyjne, sprzęt sieciowy) oraz programowe

(oprogramowanie systemowe, oprogramowanie użytkowe, dane przechowywane w

pamięciach masowych).

Podstawowym składnikiem nowoczesnego środowiska

cyfrowego jest sprzęt komputerowy. Głównymi elementami komputera są:

Przechodząc do płyt głównych

warto na wstępie zwrócić uwagę na pewien detal nomenklaturowy. W handlu płyty

główne komputerów występują pod dwoma nazwami: jako płyty główne oraz jako

platformy serwerowe. Ta druga wersja (tj. platformy serwerowe), to znacznie

lepsze (i droższe) wykonanie płyty głównej, na bazie której można zbudować

samodzielnie bardzo dobry komputer składany z części, nadający się do pracy nie

tylko jako serwer, ale również doskonała stacja robocza. Do takiego lepszego

wyposażenia należy często na platformach serwerowych kontroler pamięci,

pozwalający na korektę błędów (typ ECC - ang. Error Correction Code.). Taka

pamięć np. zamiast słów 64-bitowych jest zorganizowana w banki słów 72-bitowych,

gdzie dodatkowe bity używane są do przechowania kodu nadmiarowego, pozwalającego

na korektę 1 uszkodzonego bitu i sygnalizację 2 uszkodzonych bitów

[11] . System operacyjny oraz oprogramowanie użytkowe zainstalowane na komputerze z pamięcią ECC zachowują się znacznie bardziej stabilnie, niż na komputerach z

pamięcią zwykłą.

Oprócz kontrolera pamięci ECC, płyta główna może mieć

pewną liczbę wbudowanych na stałe, dedykowanych kontrolerów. W pierwszym rzędzie

należy tu wymienić kontrolery twardych dysków (tu do najpopularniejszych należą

standardy przemysłowe IDE i SCSI), kontrolery stacji dyskietek oraz kontrolery

zarządzające magistralami systemowymi. Tych ostatnich może być więcej niż jedna.

Płyta zapewnia komputerowi tym większą wydajność, im szersze (w znaczeniu

bitowym) są magistrale systemowe, oraz im wyższa jest na nich szybkość

taktowania zegarowego. Dawniejsze typy architektury płyty głównej nadawały

najwyższą przepustowość krótkiej magistrali, na której lokowano tylko procesor i

pamięć, natomiast wszystkie urządzenia wejścia-wyjścia umieszczano na znacznie

wolniejszej magistrali wejścia/wyjścia. Rozbudzenie masowego zapotrzebowania na

zaawansowaną grafikę, a zwłaszcza film, oraz potrzeba szybkiego dostępu do sieci

znacznie zmieniło typ architektury płyt głównych. Żartobliwie można by

powiedzieć, że technologiczna demokracja przestała tolerować elitarne magistrale

dla VIP-ów. Specjalnie dla notebooków opracowano specyfikację magistrali ZV

(Zoomed Video), a dla desktopów – magistrali AGP. Na początku XXI wieku trudno

już dostać karty graficzne PCI – przestawienie nowych kart graficznych na

standard AGP jest właściwie całkowite. Tej demokratyzacji bynajmniej nie

wymusiły badania naukowe. To pojawienie się szybkich gier sieciowych (Quake)

zażądało od producentów zmian technologicznych w płycie głównej i zwiększenia

przepustowości magistral wejścia – wyjścia, na których przecież instalowane są

adaptery sieciowe. Ale i te niedawne nowinki błyskawicznie tracą na aktualności.

Na areną wchodzi nowy standard – magistrala 3GIO (podsystem wejścia/wyjścia

trzeciej generacji) obecnie nazwana PCI-Express (teraz nawet nazwa długo nie

pożyje). Nowa magistrala w odróżnieniu od „klasycznej” równoległej magistrali

PCI jest magistralą szeregową, nieporównanie szybszą od swej poprzedniczki

(Leśniorowski [2002]).

„Przesiadkowanie” komputerów na nowe standardy

odbywa się jednak stopniowo. Na płytach głównych od dawna współistnieją koło

siebie starsze i nowsze wersje standardów przemysłowych. W starszych wersjach

komputerów obok starych gniazd ISA producenci dostawiali gniazda VESA Local Bus.

Potem obok gniazd ISA wbudowywano gniazda PCI, teraz obok gniazd PCI montowane

są gniazda AGP. Płyty główne popularnych komputerów cierpią na chroniczne

rozdojenie. Polimorfizm rozszerzającego gniazda wprowadza nieuchronne konflikty.

Kontroler SCSI-2 osadzony w gnieździe ISA kłócił się z kontrolerem VESA Local

Bus, brak karty graficznej w gnieździe AGP (starszego typu karta jest w

gnieździe PCI) powoduje wadliwe zachowanie kontrolera USB, itp.

Ostatnio

ujawniony został pewien problem, który może wzrosnąć się do niepokojących

rozmiarów. Microsoft opublikował na sieci (

http://www.microsoft.com/hcl/results.asp) listę zgodności rynkowego sprzętu z platformami Windows. Przeglądając tą listę spostrzega się zastanawiające zjawisko. W klasie płyt głównych na 6

porównywanych systemów operacyjnych (XP, 2000, Me, XP 64 bity, NT 4.0, 98) do

rzadkości należą płyty, które mają mikrosoftowski atest zgodności z trzema

różnymi systemami. Zdumienie budzi fakt, że np. dla popularnych płyt ASUS

A7M266-D [ ], A7N266 [ ], A7N266-E [ ], A7V266-EX [ ], czy P4B266-E [USB],

wydany został atest na zgodność z Windows XP, ale taki atest nie został wydany

na zgodność z dawniejszymi systemami: Windows 2000, Windows NT 4.0 i Windows 98.

Wydawać by się mogło, że najnowsza mutacja rodziny systemów Windows jest

najbardziej wymagająca pod względem sprzętowym i sprzęt mający atest zgodności z

Win XP bez najmniejszych problemów powinien spełniać wymagania starszych

systemów. Cytowany dokument zdaje się przeczyć takiej wizji. Jednak na

wymienionej liście istnieje szereg pozycji, posiadających atest dla wszystkich

trzech najnowszych, 32-bitowych systemów operacyjnych. Tak np. należą do nich

dwie płyty firmy ABIT: ABIT-TH711 [ ] oraz BL7 [ ], czy też dwie płyty firmy

AOpen: MX36LE-U [ ] oraz MX36LE-UN [ ]. Brak jest szczegółowych danych o

okolicznościach zestawienia prezentowanej przez Microsoft listy zgodności

sprzętowej i prawdziwej naturze braków pewnych atestów. Jeśli atest jest

odpłatną usługą świadczoną przez Microsoft producentom sprzętu (tak, jak np.

homologacja urządzeń telekomunikacyjnych), to wówczas trudno by się dziwić, że

producenci sprzętu testują przede wszystkim swoje najnowsze płyty i to głównie

pod kątem zgodności z najnowszym systemem (XP). Jeśli jednak Microsoft testował

wszystkie punkty tabeli (prawdziwie ogromna praca), to brak wydanych atestów w

ponad 50% testowanych płyt nie wróży nic dobrego nieświadomemu użytkownikowi. Z

powyższego wynika, że w licznych przypadkach (dla 100 pierwszych płyt na liście

75% pozycji nie ma atestu) instalacja nowego oprogramowania na starych

komputerach może pociągać za sobą niestabilność pracy systemów operacyjnych i

zawieszanie się aplikacji. Przyczyną tego typu defektu jest dychotomia

konfiguracyjna kompletnego systemu: producent oprogramowania nie produkuje

sprzętu, producent sprzętu nie produkuje oprogramowania. Brak należytego

przepływu know how pomiędzy tymi dwoma grupami producentów wytwarza

niejednoznaczności i przewidywalność zachowania się systemu staje pod znakiem

zapytania.

Procesor to główny i

najbardziej obciążony zadaniami element komputera. Praktycznie tu realizowane są

wszystkie operacje na danych cyfrowych. To od mocy przetwarzania procesora

zależy komfort pracy użytkownika. Elementami charakteryzującymi procesor

są:

Pamięć komputera dzieli się na

pamięć operacyjną, służącą do pomieszczenia aktualnie wykonywanego programu i

pewnej ilości potrzebnych do jego pracy danych, oraz pamięć masową, która jest

stosowana jako przechowalnia zarówno danych, jak i oprogramowania.

Pamięć

operacyjna to pamięć z dostępem swobodnym (ang. Random Access Memory, RAM). Czas

dostępu nie zależy w niej od adresu komórki pamięci, do której program aktualnie

się odwołuje. W stosowanej obecnie technologii pamięć operacyjna komputera

wykonywana jest w technologii półprzewodnikowej (nieporównanie tańszej od

stosowanej dawniej pamięci magnetycznej na rdzeniach ferrytowych). Od strony

technologicznej dzieli się ona na dwa typy: pamięci stałej przeznaczonej

wyłącznie do odczytu (ang. Read-Only-Memory, ROM) oraz pamięci Pisz/Czytaj,

używanej zarówno do odczytywania, jak i do powtarzalnego zapisu (ang.

Read/Write, R/W RAM).

Obecnie pamięci ROM zapisane wyłącznie przez

producenta zanikają na rzecz pamięci programowalnych przez użytkownika (ang.

Field Programmable ROM). Ważną klasą pamięci PROM są pamięci reprogramowalne

EPROM

[13] , których zawartość można wymazać, a po wymazaniu ponownie zapisać. Pamięci EPROM dzielą się z kolei na dwie podklasy. W pierwszej podklasie wymazywana może być tylko całość zapisanej

informacji przez naświetlenie półprzewodnikowej struktury światłem

ultrafioletowym przez wbudowane okienko kwarcowe (UV-EPROM). W drugiej podklasie

wymazywanie realizowane jest elektrycznie, ale i tu występuje znaczna rozmaitość

produktów. Firma Atmel [1998], jeden z czołowych producentów tych pamięci,

wyróżnia następujące linie wymazywalnych elektrycznie pamięci: Flash, DataFlash

oraz EEPROM. Te pierwsze zalecane do przechowywania modyfikowalnych w systemie

programów, drugie – do modyfikowalnych w systemie danych i trzecie do często

modyfikowalnych programów i danych. Te ostatnie dodatkowo występują w dwóch

wersjach: z interfejsem równoległym i szeregowym. Oprócz typu interfejsu i

dostrojenia struktury półprzewodnikowej do częstotliwości odwracalnych cykli

zapisywania/wymazywania, pamięci te różnią się między sobą organizacją dostępu:

od operacji na poszczególnych bajtach (EEPROM) do operacji na blokach (Flash).

Popularne już już nazwy Compact Flash lub Flash Disk anonsują odbiorcy użytkowe

cechy dysku, przy fizycznym produkcie nie przypominającym dysku ani

geometrycznie, ani też nie mającym żadnych wirujących elementów, jak ma to

miejsce w twardym dysku. Otóż mamy tu coś, co można by nazwać Lingua

Technologiae Imperii (trawestując Klemperera [1983]). Imperium chce podwładnemu

oszczędzić uczenia się nowej terminologii. Z istniejących pojęć tworzy zlepki o

częściowo zmienionej semantyce, która faktycznie jest semantyką zasocjowaną,

wektorową. W tym wektorze semantycznym jest składowa użytkowa i jest składowa

technologiczna.

Pamięć ROM jest wolniejsza od pamięci RAM, ale

informacja w niej przechowywana nie znika po wyłączeniu zasilania. Dzięki temu

jest używana do przechowywania standardowych programów obsługi danego komputera

takich, jak podstawowy program obsługi urządzeń wejścia/wyjścia (ang, Basic

Input/Output System, BIOS). Dla użytkownika ważną informacją jest to, że zarówno

dane, jak i programy zapisane w pamięci stałej, czynią obsługiwany przez nią

podsystem całkowicie odpornym na destrukcje pochodzenia wirusowego. Zastąpienie

pamięci PROM pamięcią zapisywalną na ogół wprowadza do systemu czynnik

niekontrolowany, który w pewnych okolicznościach może się okazać zgubny dla

systemu. W szczególności odnosi się to do współcześnie stosowanych płyt z

BIOS-em zapisanym w wymazywalnych elektrycznie pamięciach flash. Niestety, znane

są wirusy atakujące BIOS komputerów osobistych. Jeśli BIOS jest zapisany w

niewymazywalnym PROMie lub UV-EPROMie, to jest on praktycznie w 100% odporny na

zawirusowanie. W przypadku ważnych serwerów tego rodzaju architektura winna

posiadać na wyposażeniu dodatkowy komplet pierwotnie zainstalowanych modułów

BIOS-u, ale wykonany w wersji PROM, stanowiąc tzw. Master BIOS, przechowywany w

archiwum i używany tylko do wykonania replik w przypadku przestępczego, lub

nieostrożnego uszkodzenia zapisu. W większości przypadków BIOS dla danej płyty

głównej można ściągnąć z sieci, jednak nie jest to prawdziwe we wszystkich

przypadkach. Jednak często się zdarza, że komputery przeżywają swych twórców (to

spotkało wiele maszyn zrobionych przez Digital Equipment Corporation, DEC, –

prawdziwego potentata światowego jeszcze na początku lat 90-tych), a wtedy

dotarcie do podobnej dokumentacji może być coraz bardziej problematyczne.

Pamięci reprogramowalne elektrycznie (flash) to klasa podzespołów, których

produkcja przybrała charakter burzliwy na skutek masowego ich użycia w

przenośnym sprzęcie osobistym (dyktafony cyfrowe, kamery i aparaty cyfrowe) i

należy spodziewać się korzystnego dla użytkownika końcowego rozwoju tej

technologii, powiązanego z postępującą miniaturyzacją i obniżką ceny.

W

odróżnieniu od pamięci stałej, pamięć RAM jest szybka. Ma ona jednak tę wadę, że

w obecnie stosowanej technologii jest to pamięć ulotna (po wyłączenia zasilania

wpisana informacja bardzo szybko znika z pamięci). Nie wchodząc w detale

technologiczne rozlicznych rodzin pamięci RAM dobrze jest wiedzieć, że rozrzut

styku i własności tych pamięci jest bardzo znaczny i nieustannie się zmienia.

Przenaszalność modułów pamięci między komputerami różnych generacji jest zatem

więcej niż ograniczona. Wart uwagi jest też fakt, że pewien typ pamięci RAM

(statyczny CMOS) bywa wyposażany w niewielką litową baterię elektrochemiczną, co

czyni z niego całkiem niezły EPROM, cechami przypominający EEPROM. Ten typ

pamięci jest używany do przechowywania informacji o wyjściowej konfiguracji

sprzętowej komputera (tzw. SETUP CMOS). Rozładowanie baterii tej pamięci (co

następuje po kilku latach) objawia się dla użytkownika dość niemile, sprawiając

wrażenie prawdziwej katastrofy. W gruncie rzeczy całość naprawy sprowadza się w

takim przypadku do zakupu nowej baterii za kilka złotych i ponownej definicji

ustawień systemu. Ten element wprowadza do systemu okresowość zachowań, niekiedy

anonsowaną przez osobny kanał sygnalizacyjny.

Pamięć masowa zwykle jest

znacznie większa od pamięci operacyjnej, nieulotna (zapis jest trwały) ale

oferuje znacznie wolniejszy dostęp do zapisanej informacji. Wpisywanie do

pamięci na ogół ma charakter blokami sekwencyjny, a czas pozyskania zapisanej

informacji zwykle zależy od lokalizacji bloków na poszczególnych talerzach

dysku. W znakomitej większości przypadków pamięć masowa zbudowana jest z dysków

magnetycznych. Do celów archiwizacji zapisu dokonuje się również na taśmach

magnetycznych lub dyskach optycznych, czy też magneto-optycznych. Pamięć masowa

jest jednak tylko rozszerzającym dodatkiem do systemu i zostanie omówiona w

dalszej części niniejszego rozdziału (dyski, archiwizacja).

Wybrane standardy i technologie

Urządzenia wejścia – wyjścia

to niezmiernie ważny element systemu cyfrowego. Niezmiernie ważny – bo chyba

najbardziej zawodny. W kręgach związanych z technologią cyfrową panuje zresztą

opinia, że w wielkich firmach produkujących sprzęt funkcjonują specjalne

zespoły, zajmujące się projektowaniem akceptowalnego tempa zużycia

poszczególnych elementów systemów cyfrowych, a szczególnie urządzeń wejścia –

wyjścia. Zadaniem tych zespołów bynajmniej nie jest projektowanie urządzeń

trwałych – wręcz odwrotnie.

[14]

Gdzie szukać tych słabych punktów? W zasadzie prawie każdy współczesny system komputerowy jest kompozycją elementów elektronicznych i elektrycznych z mechanicznymi. Z tych trzech grup

elementów najbardziej zawodne i wymagające najczęstszej wymiany i serwisu są

elementy mechaniczne. Zaliczamy do nich: dyski magnetyczne, napędy dyskietek i

dysków optycznych, klawiatury, urządzenia pozycjonujące (mysz, trackball) oraz

wentylatory.

Urządzenia wejścia – wyjścia dołącza się do komputera przez

dedykowane gniazda komunikacyjne. Z ważniejszych należy wymienić szeregowe w

standardzie RS 232C (lub wyższe), szeregowe w standardzie USB, szeregowe w

standardzie IrDA (transmisja bezprzewodowa), szeregowe w standardzie IDE (nowy

standard do przyłączania twardych dysków), równoległe drukarkowe (Centronics),

równoległe aparaturowe (IEC 625, HP-IB, IEEE-488), równoległe w kilku klasach

standardu SCSI. Prognozy technologiczne przewidują zmniejszanie się udziału

transmisji w standardach równoległych na rzecz standardów szeregowych

(zmniejszenie ilości kabli usprawnia wydatnie wentylację i odprowadzanie ciepła,

a zarazem poprawia dostęp do podzespołów komputera w czasie serwisu).

Urządzenia wejścia – wyjścia mają swoją drogę ewolucyjną i warto trochę

ją prześledzić, ma ona bowiem swoje ważne implikacje dla życia społecznego.

Rozwój tych urządzeń z jednej strony jest stymulowany oczekiwaniami społecznymi,

z drugiej – sam wpływa na postawy konsumentów w taki sposób, by domagali się oni

dalszych zmian i innowacji. Jednym słowem w zamierzeniach jej reżyserów ma to

być samonapędzająca się maszyna, samograj. Poniższy zarys rozwojowy jest swego

rodzaju swobodną układanką trzech ciągów technologicznych. Realia są takie, że w

praktyce ciągle współpracują ze sobą urządzenia bardzo stare (np. stare

terminale znakowe Wyse 50) z najnowocześniejszymi serwerami.

Jeśli nie uwzględniać faktu,

że klawiatura bywa wykonana w wersji ergonomicznej, mającej dość wyszukany

kształt dobrany tak, by zminimalizować napięcie mięśni i ścięgien osoby

piszącej, to jest to ta część komputera, która na przestrzeni lat zmieniła się

najmniej.

Drugim etapem rozwoju

prezentacji wyników przetwarzania było pojawienie się monitora graficznego.

Najwcześniejsza mutacja realizowała wyłącznie zadania terminala znakowego, a nad

dalekopisem miała tą przewagę, że była nie tylko cichsza, ale również znacznie

szybsza. Natomiast repertuar prezentowanych na monitorze znaków był ograniczony

do zestawu znajdującego się w generatorze znaków. Następną mutacją był terminal

graficzny, dający możliwość prezentacji grafiki komputerowej. Ale i terminal

graficzny miał swój osobny rozwój. Ze zrozumiałych powodów przyjmował on (i

nadal przyjmuje) zlecenia pracy w dwóch przełączalnych programowo trybach:

graficznym i znakowym. Tryb graficzny pozwala na swobodne alokowanie fizycznej

przestrzeni pikseli ekranowych dowolną grafiką. Tryb znakowy posługuje się

podziałem ekranu na kolumny oraz wiersze wraz ze związanymi z nimi interliniami,

przydzielając każdemu miejscu przeznaczonemu na wyświetlanie znaku matrycę

pikseli zgodną z przyjętymi standardami. Ilość możliwych do zapamiętania znaków

zależała tylko od wielkości przestrzeni adresowej generatora znaków. Konieczność

szybkiego rozwoju terminali graficznych dla potrzeb obsługi tekstu

wielojęzycznego w bibliotekach dyskutował już Miller [1982]. Jednak nie w

wizualizacji znaków na ekranie monitora CRT (ang. Cathode Ray Tube) widział on

główne trudności w kompleksowym rozwiązaniu tego zagadnienia, a w klawiaturze; a

to z uwagi na jej fizyczne ograniczenia.

Kolejnym etapem rozwoju

terminali znakowych stały się terminale z ładowalnym generatorem znaków. W tym

miejscu dodamy istotne rozszerzenie dyskutowanych pojęć: to co przed chwilą

zostało powiedziane o terminalach graficznych, dotyczy też adapterów graficznych

w komputerach osobistych. Ładowalne generatory znaków stały się kamieniem

milowym na drodze rozszerzenia obsługi wielojęzycznej poza granice wyznaczone

wąskim horyzontem projektantów sprzętu komputerowego. To one umożliwiły

Młodzianowskiemu [1994] opracowanie pierwszego na świecie terminala

[15], umożliwiającego sklejanie znaków diakrytycznych z literami alfabetu angielskiego. Terminal ten był pierwszym krokiem do przyszłego terminala

unikodowego, obsługującego ekranowo nie tylko sklejanie znaków diakrytycznych z

literami, ale i obsługę ligatur. Warto dodać, że terminal ISO 6937 rozwiązał

jeszcze jeden bardzo ważny aspekt techniczny: sposób wprowadzania diakrytycznych

znaków narodowych ze standardowej klawiatury przez przedefiniowanie klawiatury

numerycznej.

Rozwój i powszechna akceptacja standardu okienkowego (Apple,

Microsoft) stworzyły nową możliwość oferowania przez aplikację dodatkowych usług

niezwykle upraszczających proces edycyjny i proces komunikacyjny. Mysz, jako

pierwsze urządzenie wskazująco – pozycjonujące, wniosła ze sobą jakościowo coś

zupełnie nowego: jak gdyby prawzór kartoteki haseł wzorcowych ze skończoną

liczbą dobrze zdefiniowanych, systemowych napisów, lub ikon, które należało

wskazać, zamiast wpisywać z klawiatury odpowiednie komendy. Wskazanie

predefiniowanego obiektu miało znacznie zmniejszyć liczbę błędów literowych.

Tego rodzaju technologia miała znacznie ułatwić komunikację człowieka z

komputerem. Połączona z kolejnymi innowacjami, takimi jak funkcja „przeciągnij i

upuść”, przesunęła ciężar komunikacji tekstowej w kierunku operacji graficznych,

szybko stając się światowym przebojem. Mysz jednak nie wyeliminowała klawiatury,

ograniczyła tylko liczbę błędów na poziomie komunikacji systemowej. Klawiatura

nadal pozostaje niezastąpiona przy wprowadzaniu danych.

Monitor oparty na lampie

kineskopowej (CRT) to ciągle bardzo popularne rozwiązanie techniczne. W stosunku

do pierwszych modeli nastąpiła znaczna poprawa jakości. Obecnie praktycznie nie

używa się już wersji monochromatycznej i powszechnie króluje monitor kolorowy. W

życie weszły drastyczne normy dotyczące emisji pola elektromagnetycznego i

szkodliwego promieniowania. Spadło napięcie przyspieszające wiązkę elektronów,

poprawiono odprowadzanie ładunku z powierzchni ekranu. Ekran przestał "strzelać"

i nie przyciąga już tak bardzo brudnego pyłu. Spłaszczyła się znacznie jego

powierzchnia. Niejednokrotnie współczesny monitor wygląda tak, jak gdyby był

wklęsły. Nowe modele są też często sterowane cyfrowo. Z pewnością jest to

jeszcze stosunkowo ciężki mebel, zajmujący sporo miejsca. Nie ma też

wątpliwości, że długotrwała praca przy takim wyświetlaczu ani nie należy do

przyjemności, ani nie jest zdrowa - nawet jeśli dysponuje się modelem z wysoką

częstotliwością odchylania. Nie ma też wątpliwości, że w takim rozwiązaniu

technicznym nikt nie widzi przyszłości i jest kwestią niezbyt długiego czasu,

gdy stary typ monitora zostanie zastąpiony przez następcę lżejszego, zajmującego

znacznie mniej miejsca i przyjemniejszego w użyciu. Jednak w roku 2002 wciąż

aktualne jest stwierdzenie, że odwzorowanie 24-bitowej palety kolorów na

ekranach CRT bije na głowę odwzorowanie barw na ekranach LCD TFT. Wadą monitorów

CRT są ciągle gabaryty i nic nie wskazuje na to, by coś się tu mogło zmienić.

Dyskietka jako medium

przenośne sukcesywnie zmniejszała swe rozmiary od 11” , przez 8”, i 5,25” do

3,5” (efemeryczny standard 3” nie będąc zaakceptowany przez największych

producentów, szybko zniknął z rynku) stając się coraz bardziej niezawodną aż do

bezterminowej gwarancji, z której producenci szybko się wycofali. Obecnie jest

to jedno z najbardziej niepewnych mediów i należy przewidywać rychłe odejście

klasycznej dyskietki 3.5”.

Sieć stała się standardem.

Ciągle funkcjonuje bardzo duża liczba sieci lokalnych o szybkości transmisji 10

Mbps, nowe buduje się prawie wyłącznie w standardzie 100 Mbps, gigabitowe sieci

są u nas bardzo rzadko spotykane.

Trzecia generacja sprzętu

do wprowadzania i prezentacji: technologia bezprzewodowa (klawiatura, mysz,

drukarka, sieć), ekran LCD /TFT, dyski wymienne w technologii

EEPROM.

Rozpowszechniają się standardy

bezprzewodowej komunikacji. Pierwszą powszechnie stosowaną technologią jest

transmisja w podczerwieni. Początkowo jest stosowana głównie do wyprowadzania

danych na drukarkę, potem do komunikacji pomiędzy palmtopami i komputerami

stacjonarnymi. Od strony ogólnej koncepcji pomysł to niezbyt nowy: do celów

telefonii bezprzewodowej wykorzystywany był już w czasie II Wojny Światowej w

Afryce przez armię Rommla, mimo bardzo trudnych technologicznie warunków (silne

promieniowanie termiczne tła). Obecnie wydaje się zwolna ustępować miejsca

bezprzewodowym połączeniom w paśmie fal radiowych wysokiej częstotliwości. Tak

np. w notebooku Siemensa-Fujitsu klawiatura komunikuje się z płytą główną w

standardzie Bluetooth [Notebooki, 2002].

W zakresie prezentacji

wizualnej na trzecim poziomie rozwoju pojawił się ekran wykorzystujących ciekłe

kryształy (LCD) w kilku różnych mutacjach. W stosunku do ekranów CRT wniósł

znacznie większy komfort pracy, redukując zmęczenie wzroku oraz – co ważniejsze

– obniżając ogromnie konsumowaną moc. Znacznie zmniejszone gabaryty ekranu

umożliwiły prawdziwą eksplozję produkcji ręcznych zegarków elektronicznych,

przenośnych urządzeń diagnostycznych (glukometry, mierniki ciśnienia krwi),

komputerów podręcznych, kieszonkowych, palmtopów, telefonów komórkowych. Kolejne

mutacje technologii ciekłokrystalicznej są coraz lepsze – wydatnie zmniejszyło

się smużenie; skrócił się czas odpowiedzi ekranu, ale odwzorowanie ciągłej

palety barwnej na ekranach CRT nadal charakteryzuje się wyższą jakością.

Pojawia się zewnętrzna pamięć

masowa ze zmienioną technologią zapisu: następuje odejście od zapisu

magnetycznego na rzecz nieulotnego zapisu elektrycznego w pamięciach

reprogramowalnych elektrycznie (EEPROM). Zniknięcie czynnika mechanicznego

znacznie podwyższa niezawodność zapisu. Styk tej pamięci z komputerem

realizowany jest galwanicznie, kabel transmisyjny jest zarazem kablem

zasilającym (USB). Nowa technologia zauważalnie obniża gabaryty przyłączanego

urządzenia.

Masowa produkcja komputerów przenośnych i rozwój telefonii

komórkowej doprowadziły do konwergencji tych dwóch technologii. Komputery

przenośne włącza się do Internetu za pośrednictwem telefonii komórkowej, a w

telefonach komórkowych zaczyna się wprowadzać przesyłanie krótkich wiadomości w

wersji tekstowej (SMS) – pierwszą usługę cyfrową, oraz WAP – bezprzewodowy

protokół obsługi aplikacji sieciowych. Pojawiają się komunikatory - pierwsze

konstrukcje będące wynikiem integracji przetwarzania cyfrowego i komunikacji

bezprzewodowej; obecnie jeszcze bardzo drogie, ale wróży im się świetlaną

przyszłość.

W pewnych warunkach, na

przykład w bibliotecznych czytelniach czy konferencjach prasowych, używanie

głosu do wprowadzania informacji czy sterowania komputerem jest niewskazane. Na

podobne okoliczności firma Senseboard Technologies AB zaproponowała ostatnio

interesujące rozwiązanie nazwane przez twórców wirtualną klawiaturą. Służy ona

do obsługi miniaturowego sprzętu osobistego. Składa się ona z nakładek na

dłonie, bezprzewodowego systemu transmisyjnego w paśmie wysokich częstotliwości

oraz oprogramowania. Nakładki zawierają czujniki przemieszczeń palców tak, że

pisać można dosłownie na narysowanej na papierze klawiaturze nie połączonej

fizycznie z komputerem, do którego informację się wpisuje.

Rysunek 1.

Wirtualna klawiatura. Dzięki uprzejmości Senseboard Technologies AB.

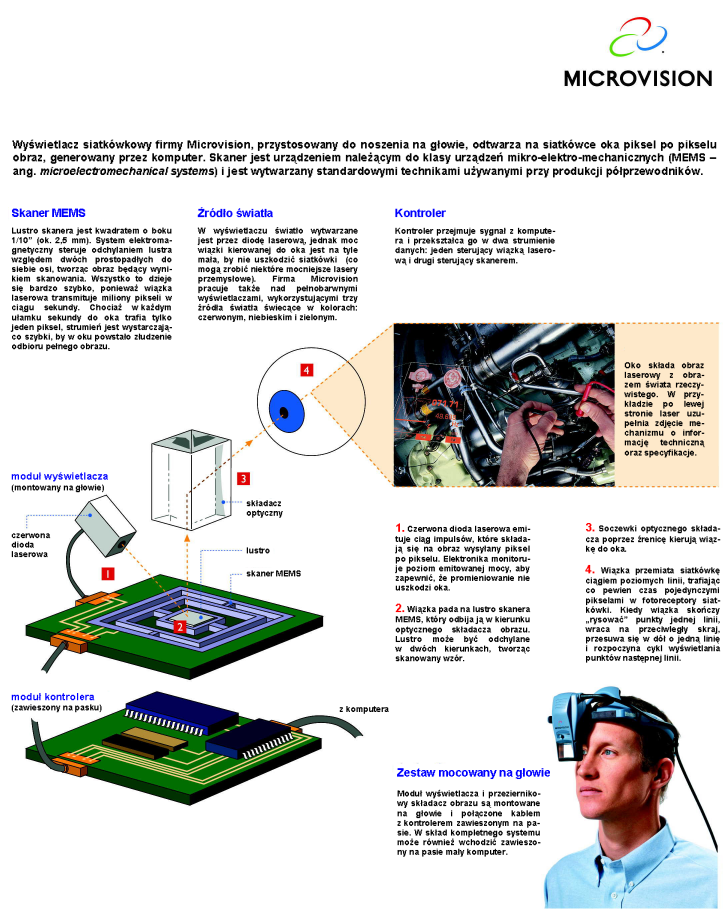

W zaawansowaną fazę rozwoju wchodzi obrazowanie bezpośrednie na siatkówce oka. Za przykład realizacji takiego rozwiązania posłużą tu produkty firmy Microvision, które w chwili obecnej pozwalają sprawnie sumować na siatkówce dwa obrazy: jeden rzeczywisty, drugi generowany przez komputer.

Rysunek 2. Składanie na siatkówce oka obrazów rzeczywistych z obrazami generowanymi przez komputer w systemie Nomad.

Rysunek 3. Testowanie punktu kontrolnego układu elektrycznego. Z lewej strony rysunku, również na tle elementów mechanicznych, widoczny jest w postaci czerwonych linii obraz panelu oscyloskopu cyfrowego, podający analogowy przebieg sygnału (sinusoida) oraz wartości cyfrowe napięcia i częstotliwości. Rysunek publikowany jest dzięki uprzejmości firmy Microvision Incorporated.

Firma Microvision twierdzi, że

poziom energii wiązki laserowej skierowanej na siatkówkę oka jest bardzo niski i

nie szkodzi wzrokowi. Przy tej okazji warto jednak przypomnieć, że już wiele lat

temu firma Barco, produkująca trójstrumieniowe projektory graficzne, w których

źródła światła stanowiły przysłonięte filtrami RGB lampy kineskopowe, znalazła

ciekawe i proste rozwiązanie, zapobiegające wypalaniu luminoforu lamp przez

niezwykle silną wiązkę elektronów. Polegało ono na programowej, powolnej,

mimośrodowej rotacji środka obrazu (nazwanej przez producenta orbiting software)

z okresem około 5 minut. Microvision nic nie pisze o podobnym rozwiązaniu, choć

wydaje się, że można by je tu zastosować z doskonałym skutkiem.

Rozpoczęto pierwsze próby

z bezpośrednim wprowadzeniem sygnału elektrycznego z kamery wprost do mózgu

osoby niewidzącej z zamiarem utworzenia substytutu wzroku (

http://www.dobelle.com/asaio1.html). Celem ich jest doprowadzenie do rozróżnienia na poziomie centralnego układu nerwowego obszarów jasnych i ciemnych. Metoda wykroczyła już dalece za

laboratoryjne eksperymenty i nieproduktywne teoretyzowanie. Dobelle [2000]

referuje zbiorcze wyniki świetnie zaprojektowanych dwustopniowych badań z

udziałem ochotników widzących, którzy z różnych względów musieli być poddani

operacjom oczu, oraz osób całkowicie niewidomych. Tak dobrane, podlegające

badaniom zbiorowości, gwarantowały wysoki stopień wiarygodności wyników. Idea

metody polega na wprowadzeniu specjalnie uformowanych sygnałów elektrycznych,

otrzymywanych z miniaturowej kamery telewizyjnej, bezpośrednio do

odpowiedzialnej za widzenie części kory mózgowej. Kanał transmisyjny wyposażono

dodatkowo w splitter, pozwalający przełączyć sygnał z kamery na sygnał wysyłany

wprost z komputera. To rozwiązanie miało umożliwić rehabilitowanemu ochotnikowi

wykonywanie ćwiczeń w środowisku sprzętu komputerowego, tak niezbędnego obecnie

w prowadzeniu pracy zawodowej. Stymulujące impulsy były odbierane przez

ochotników jako prostokątna siatka plam białych i czarnych, które autor nazywa

fosfenami (ang. phosphenes). Wnioski płynące z trwającego 20 lat eksperymentu są

ze wszech miar pozytywne. Po przełamaniu trudności wstępnego okresu

rozpoznawanie kształtu testowych znaków przez niewidomego stało się rutynowe.

Należy jednak pamiętać, że ciągle jest to jeszcze etap badań i rozwoju metody.

Zdolność rozdzielcza matrycy stymulowanych punktów jest ciągle niska, obraz jest

płaski bez jakichkolwiek cech przestrzenności, brak koloru, brak półtonów.

Istnieją podejrzenia, że stymulację należy rozpoczynać możliwie szybko, by nie

dopuścić do zaniku zdolności recepcji. Wydaje się, że naukowcy ciągle jeszcze

mają zbyt mało rozpoznane protokoły transmisji między receptorami a centralnym

systemem nerwowym. Z pewnością też za słabo zbadana została biofizyka pola

recepcyjnego. Problemem jest zarówno poziom, jak i charakter sygnału (Chemiczny?

Elektryczny? Mieszany?). Bardzo potrzebne są nieinterwencyjne metody

pomiarowe.

Program satelitarnej telewizji

francuskiej PLANET wyemitował w maju 2002 film „Koniec tajemnic” (La fin des

secrets) w reżyserii Marie Arnaud i Delphine Morel. Film prezentował szereg

współczesnych osiągnięć w zakresie sztucznej inteligencji. Jednak to nie systemy

inteligentnego rozpoznawania twarzy były warte utrwalenia w pamięci. Także nie

widok szczura z implantem mózgowym, niosącego na głowie moduł elektroniczny z

zasilaczem, upiększony radiatorem niczym koroną – szczura sterowanego pilotem! –

pozostawiał na widzu wstrząsające wrażenie. To wrażenie (niekoniecznie

pozytywne) pozostawił profesor uniwersytecki pracujący nad sztuczną

inteligencją, który demonstrował, jak funkcjonuje na terenie budynku

zaprojektowany przez niego system lokalizacji człowieka, mającego wszczepiony

implant chipowy. Człowiek ów dzielił się wrażeniami, jakie wywiera na nim

integracja z budynkiem. Dialog „Cześć budynek! ” – „Witaj profesorze XY” oddaje

już pewną poufałość, zażyłość. Fascynacja człowieka własnymi wynalazkami i

konsekwencje tej fascynacji nieraz były przedmiotem twórczości artystycznej.

Film „Koniec tajemnic” ma jednak w podtekście świeżo zrealizowane projekty

lokalizacji więźniów w więzieniach amerykańskich, że wspomnieć tak niedawno

popularny film Matrix. Widok plamki, lokalizującej żywego człowieka na

wyświetlonym na ekranie planie budynku skłania do zadania pytania, czy w tym

schemacie czystej nauki znajdzie się miejsce na jakąś intymność i prywatność;

czy zostanie zachowane choć jedno pomieszczenie w budynku z którego do zarządcy

systemu nie dochodzi informacja czy pracownik siedzi, czy też stoi, i z którego

nie transmituje się odgłosów online?

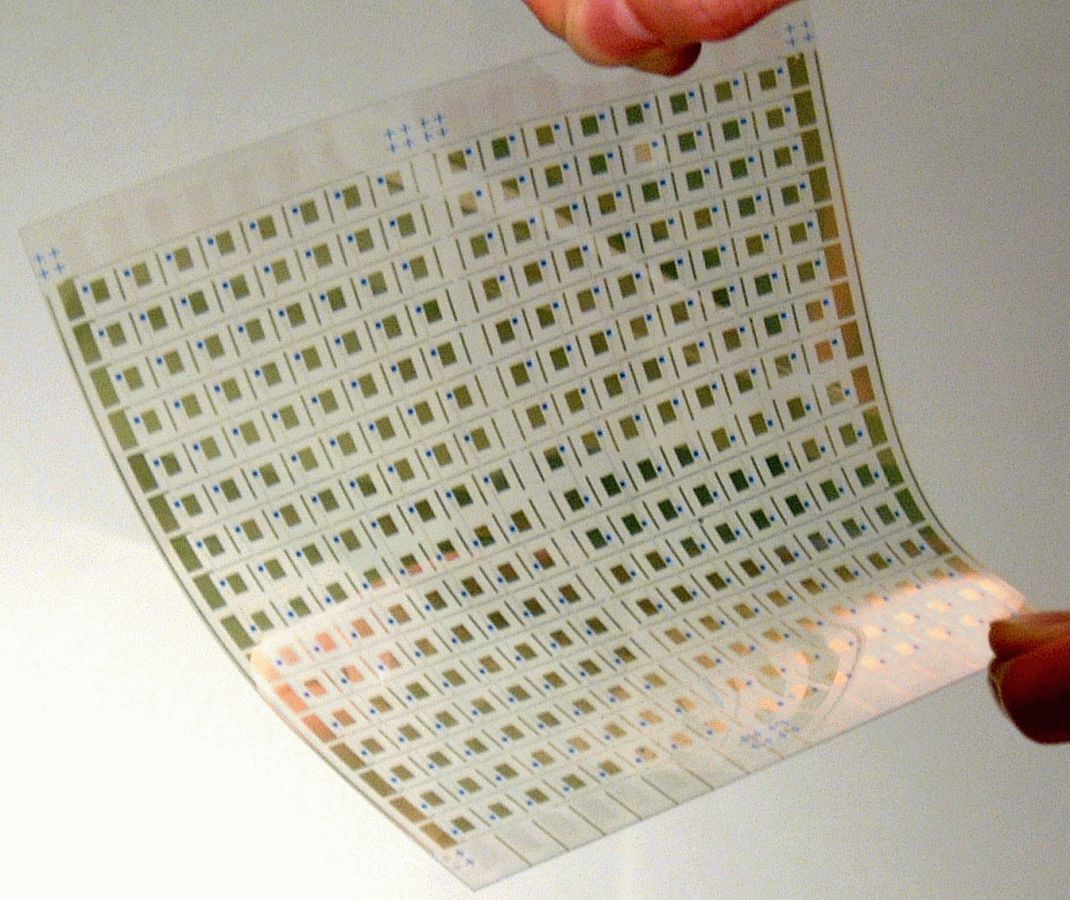

Już w tej chwili mamy przedsmak nadchodzącej przyszłości w zakresie prezentacji: firma Lucent Technologies we współpracy z E-Ink opracowała elestyczny foliowy ekran, który można zwijać i wkładać między karty książek i zeszytów. To już tylko krok do ładowalnej książki! Być może zakup książki przez Internet nie będzie już wymagał istnienia księgarń. Książkę będzie się ładować z sieci wprost z serwera domu wydawniczego. Dzieci uczęszczające do szkół odbiorą ładowalną książkę jako prawdziwą rewolucję. Skończy się noszenie ciężkich tornistrów z domu do szkoły. Zasób pomocy dydaktycznych (książki, mapy, zbiory zadań) na cały rok będzie się mieścił na jednym tanim i niewielkim CD-ROMie. Jedna książka ładowalna będzie stanowić chwilową kompozycję materiału dydaktycznego ze wszystkich przedmiotów np. na jeden tydzień. Zestaw potrzebnego na lekcje materiału uczeń będzie mógł sobie załadować w domu pod opieką rodziców, a w szkole pod opieką nauczyciela - lub - bibliotekarza. Po pierwszym okresie sprzętowych inwestycji ceny materiałów edukacyjnych gwałtownie się obniżą. Można przypuszczać, że poziom konsumpcji tej książki przez światowe systemy edukacyjne może być ogromny i to właśnie będzie stanowić źródło obniżki kosztów produkcji. Kartki książki ładowalnej prezentować się będą znacznie lepiej niż wiele książek współczesnych. Będą one wykonane z tworzywa sztucznego o znacznej większej odporności na działanie wody, poplamienie i rozdarcie, niż papier tradycyjny. Czytać ją będzie można w tramwajach i kolejce elektrycznej. Jeśli zaczną zanikać księgarnie to "w powietrzu wisi" gwałtowny spadek zapotrzebowania na tradycyjną poligrafię. Tak jak niedawno zniknęły linotypy, tak niedługo znikną naświetlarki folii i nikt już więcej nie będzie robił wyciągów barwnych. Znikną profesjonalne drukarki termodyfuzyjne i inne podobne im urządzenia. Powoli zaczną znikać stołowe skanery. Z pewnością od tej chwili dzieli nas jeszcze kilka lat, jednak nie jest to rozważanie abstrakcyjne lecz wyciąganie wniosków z perspektyw rozwojowych aktualnie opanowanej technologii, która jest udoskonalana. Zatem wszelka dyskusja na powyższy temat nie powinna być prowadzona w kategoriach „czy?”, lecz „kiedy?”.

Rysunek 4. Wyświetlacz foliowy. Dzięki uprzejmości Lucent Technology.

Materiałem wyświetlacza jest folia z tworzywa sztucznego, w której zdyspergowano mikrokapsułki zawierające pigment zawieszony w cieczy przypominającej atrament. Na razie zapis jest jednobarwny, ale trwają intensywne prace badawcze nad realizacją wyświetlacza kolorowego. Wyświetlacze te obecnie wykonuje się zarówno w postaci przezroczystej folii, jak i na podłożu nieprzezroczystym. Ze względu na możliwość realizacji trwałego zapisu nowa technologia stwarza realne perspektywy masowej produkcji tanich, elektronicznych, wielokrotnie zapisywalnych przez użytkownika książek, do złudzenia przypominających książki drukowane. W chwili obecnej technologia ta cechuje się niezbyt wysoką zdolnością rozdzielczą szczegółów – jest ona rzędu 200 dpi (a więc znacznie lepszą, niż obraz uzyskany z tzw. zrzutu ekranu monitora komputerowego), ale ta granica niustannie się podnosi.

Godne uwagi jest to, że w

przypadku użytkownika niewidomego monitor wcale nie jest potrzebny (chyba, że

stanowisko jest współużytkowane przez osoby widzące). Dobitnie dał temu wyraz

Raman [1997], odwołując się do czynnika technicznego. Wyłączenie wyświetlacza w

jego notebooku pozwalało na dłuższą pracę z zasilaniem bateryjnym

[16]. Problem dedykowanego, taniego komputera bez drogiego monitora po dzień dzisiejszy w ogóle nie został na świecie rozwiązany. Konsekwencją tego są

niezmiennie wysokie koszty ponoszone zarówno przez rodziny niewidomych, jak i

sponsorów [Czermiński 2000-2]. Byłoby rzeczą niesłychanie wartościową

opracowanie oszczędnościowej wersji komputera osobistego dla osób niewidzących,

wyposażonego w mały i tani panel ciekłokrystaliczny dla prac instalacyjno -

diagnostycznych prowadzonych przez osoby widzące. Problem ten nie jest

trywialny, bo w zasadzie wiąże się z odejściem od powszechnie używanego

interfejsu graficznego użytkownika (ang. Graphical User Interface, GUI) na rzecz

interfejsu znakowego oraz z opracowaniem od nowa całej koncepcji klienta dla

osób niewidzących. Obecnie stosowane rozwiązania nakładają się na istniejące

oprogramowanie użytkowe, mają wiele wad i są bardzo kosztowne. Obszerny przegląd

technologii alternatywnych dla inwalidów można znaleźć w doskonałej monografii

Barbary Mates [2000], wydanej staraniem Amerykańskiego Stowarzyszenia

Bibliotekarzy. Na Rysunku 5 przedstawiony jest tzw. 45 - cio znakowy monitor

brajlowski (zwany też linijką brajlowską), odwzorowujący dynamicznie w

8-punktowym zapisie Braille'a połowę jednego wiersza ekranu (40 znaków).

Odwzorowanie obejmuje jedynie część znakową ekranu (bez grafiki). Podłużne

przyciski pomiędzy matrycą brajlowską a klawiaturą pozwalają na błyskawiczne

przestawienie kursora na pozycję odpowiadającą danemu znakowi. Pięć

nadwyżkowych, wydzielonych pozycji z lewej strony to blok sterujący (służy

między innymi do odczytywania drugiej połówki wiersza ekranu). Jak widać,

monitor brajlowski jest podkładką umieszczaną pod zwykłą klawiaturą, co

znakomicie integruje niewidomemu cały system. Dodać tu należy, że niewidomi z

zasady mają doskonale opanowany rozkład klawiszy zwykłej klawiatury, tak jak

profesjonalne maszynistki (które przecież też nie patrzą na klawisze) i piszą

bardzo szybko. Ze zrozumiałych powodów powierzchnia klawiszy w klawiaturach

używanych przez niewidomych jest gładka - brajlowskie wypukłości odczuwało by

się bardzo niemile podczas pisania.

Rysunek 5. Piezoelektryczny monitor brajlowski. Dzięki uprzejmości firmy Tieman.

Dyski magnetyczne, wymienione

wyżej na pierwszym miejscu listy głównych elementów komputera, mają relatywnie

wysoką podatność na awarię. Awaria może być spowodowana szeregiem różnych

czynników: uderzeniem lub wstrząsem, Z całą mocą należy tu podkreślić, że awaria

dysku głównego serwera biblioteki może mieć pełne cechy prawdziwej katastrofy,

powodującej przepadek dorobku wielu lat pracy; katastrofy prawdziwie trudnej do

zniesienia. Do takiej katastrofy nie wolno dopuszczać, ale na jej nadejście

trzeba się przygotować. Ona kiedyś nadejdzie, choć nie wiadomo kiedy. Si vis pacem para bellum. Biblioteka

dysponująca własnym serwerem i nie mogąca sobie pozwolić na tydzień przestoju,

absolutnie powinna dysponować zapasowymi dyskami systemowymi, co pewien czas

włączanymi do pracy i testowanymi w pełnym ruchu usług. Temat ten szerzej

poruszymy przy okazji omawiania bezpieczeństwa i archiwizacji.

Macierze dysków zewnętrznych z

interfejsem sieciowym to coraz popularniejszy element najbliższego otoczenia

współczesnych serwerów. W zgrabny sposób pozwalają one współdzielić zasoby

takiej pamięci masowej przez kilka serwerów (nawet o różnych systemach

operacyjnych), charakteryzując się zarazem prostą administracją. Zwykle

wykonywane są w konfiguracji RAID (ang. Redundant Array of Inexpensive Disks) z

możliwością odtworzenia uszkodzonego bloku danych. Nowe modele mają możliwość

wymiany uszkodzonych dysków w czasie pracy systemu bez wyłączania zasilania

(ang. Hot Swap, HS). Do niedawna strukturę RAID realizowało się wyłącznie na

drogim interfejsie SCSI. Ostatnio pojawiły się kontrolery RAID obsługujące

interfejs IDE, a zatem umożliwiające korzystanie ze znacznie tańszych dysków.

Ten typ urządzenia zdecydowanie winien się znaleźć w obszarze zainteresowania

bibliotek, od których w szczególnej mierze oczekuje się bezawaryjności systemu.

Półprzewodnikowe pamięci wymienne (dyski wymienne).

Szybko rozwija się produkcja pamięci półprzewodnikowych, które nie zawierają żadnych części ruchomych i być może już wkrótce zastąpią dyski magnetyczne. Można przypuścić, że za jakiś czas ten typ pamięci zacznie dominować nad dyskami, a to z uwagi na brak części ruchomych, co gwarantuje znacznie większą niezawodność. Już teraz można zakupić taką pamięć w wersji Disk-On-Chip, którą można włożyć do pustej podstawki układu scalonego, ale na razie zarówno pojemność, jak i cena nie stanowią konkurencji dla dysków. Jest rzeczą interesującą, że już w obfitości pojawiły się w handlu przenośne pamięci masowe wykorzystujące technologię flash, pod handlową nazwą Pen Drive (Rysunek 6) – wielkością swą rzeczywiście nie większe od kciuka dorosłego mężczyzny, łączone z komputerem poprzez port USB (na razie w standardzie 1.1).

Rysunek 6. Pamięć masowa Pen Drive. Dzięki uprzejmości QART Serwis s.c.

W chwili przygotowywania

do druku niniejszej książki pamięci te wykonywane są w pojemnościach od 8 MB do

1 GB. Doświadczenie kilku miesięcy pracy z 32 MB Pen Drive’m pozwala autorowi

wystawić tej technologii wysoką ocenę, aczkolwiek pojawiły się pierwsze

zachowania wskazujące problemy z kontaktem elektrycznym. Pamięć ta ma małe

gabaryty (można ją nosić jak długopis w kieszonce) i dużą pojemność przy

akceptowalnej (na poziomie 32 MB) cenie. Brak ruchomych części sprawia, że w

stosunku do dysków i dyskietek zapisywanie na niej będzie się cechowowało

podwyższoną niezawodnością. Jest ona nadto wyposażona w przełącznik blokady

zapisu. Model, który kupił autor wymagał sformatowania jak zwykły dysk. Pracuje

bez zarzutu pod Win 98 i 2000; po wetknięciu w gniazdo USB sam zgłasza się

systemowi jako „Wymienny dysk”. Osobliwość pod Win 2000: choć nie potrzeba go

instalować tak jak w UNIX-ie, to przed wyjęciem należy go odinstalować poprzez

ikonę, która pojawia się w pasku zadań w momencie wetknięcia urządzenia do portu

USB. Co ciekawe: producent oferuje opcjonalną dostawę pamięci z ładowalnym

systemem operacyjnym i ochroną dostępu na poziomie hasła. Fakt ten nasuwa uwagę,

że być może jest to pierwszy krok do realizacji miniaturowych komputerów

modularnych. Jednak problemy ze stykiem zdają się wskazywać, że również i ta

konstrukcja jest formą przejściową, a prawdziwą przyszłość należy widzieć w

urządzeniach połączonych bezprzewodowo. Opisany tu model bez problemu instaluje

się bezpośrednio w gniazdku USB, ale w przypadku wykorzystywania obydwu bardzo

blisko koło siebie położonych gniazdek USB naeleży posłużyć się przedłużaczem.

Warto odnotować, że już na rynku pojawiły się modele o znacznie bardziej

zminiaturyzowanych gabarytach, które nie mają powyższego ograniczenia.

Pen Drive’a można używać jako

doskonałego medium do przechowywania klucza prywatnego oraz kluczy publicznych

osób posługujących się podpisem elektronicznym. W związku z wykryciem w marcu

2001 braku ochrony zarówno publicznych parametrów jak i klucza publicznego w

pakiecie klucza prywatnego (plik secring.skr) zarówno odkrywcy nieszczelności,

czescy kryptolodzy Vlastimil Klima i Tomáš Rosa [2001], jak i twórca Pretty Good

Privacy (PGP) Phil Zimmerman (

http://news.zdnet.co.uk/story/0,,t269-s2085201,00.html), zwrócili uwagę, że podstawą do przejęcia klucza prywatnego jest uzyskanie przez włamywacza kontroli nad plikiem, w którym jest on przechowywany. Pen Drive jest

już urządzeniem niezbyt drogim i daje daleko większe poczucie prywatności niż

zwykła dyskietka. Tego rodzaju rozwiązania (tzw. klucz USB) są już sprzedawane

przez firmy oferujące sprzęt, oprogramowanie i usługi z zakresu zarządzania

bezpieczeństwem systemów komputerowych.

Archiwizatory.

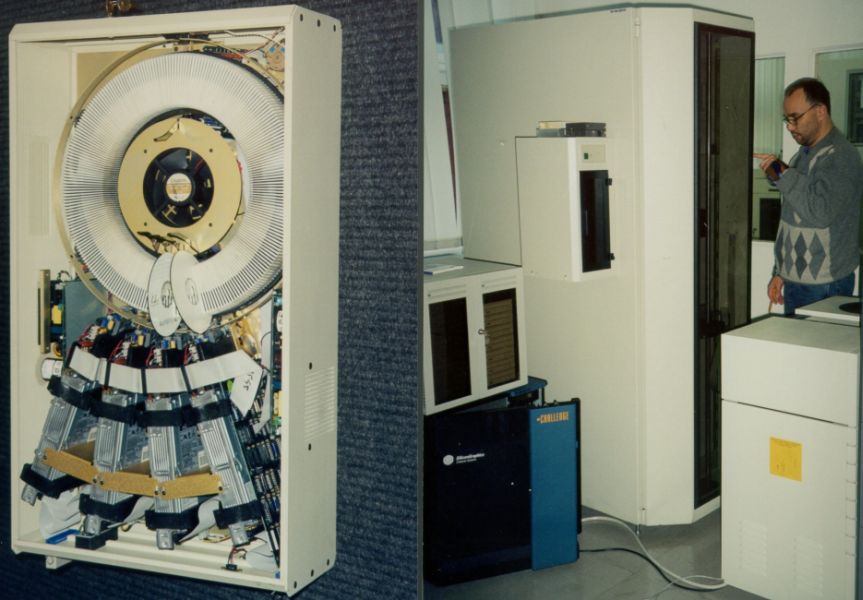

Archiwizatory to urządzenia do sporządzania kopii bezpieczeństwa oprogramowania oraz danych. Wykonuje się je w trzech dominujących technologiach: z zapisem magnetycznym, optycznym, lub hybrydowym - magnetooptycznym. Archiwizator powinien oferować możliwość oddzielenia medium zapisu od urządzenia zapisującego i przechowywania archiwum z dala od archiwizowanego oryginału. Do archiwizatorów nie należy zaliczać systemów sporządzania kopii na 'lustrzanych' dyskach (ang. mirror disk), ponieważ zwykle nie spełniają one wymagania przenośności medium. Przy okazji warto sobie uświadomić, że struktura RAID jest znacznie bardziej ekonomiczna od lustrzanego dublowania dysków. Klasyczną formą archiwizacji była, i ciągle pozostaje, archiwizacja na kasetkach magnetycznych DAT z sekwencyjnym dostępem do danych. Pojemność tych kasetek w przeciągu ostatniego dziesięciolecia zwiększyła się rzędy wielkości razy. W niedawno wprowadzonej technologii LTO Ultrium pojedynczy napęd HP SureStore Ultrium 230 oferuje archiwizację 200 GB przy szybkości transferu 30 MB/s (Rzeźnicki [2001]). Szybki wzrost pojemności dysków w dużych serwerach sprawia jednak, że kolejne generacje rozwojowe Ultrium zapowiadają archiwizację 1.4 TB na pojedynczym nośniku. Trzeba jednak pamiętać, że urządzenia te są bardzo drogie. Duże systemy mają wbudowaną dedykowaną robotykę, prowadzącą całą obsługę wymiany kaset. Rysunek 8 przedstawia zdjęcie dużego taśmowego archiwizatora z wbudowaną robotyką. Prezentowana jednostka jest jednym z elementów systemu archiwizacji w Centrum Informatycznym Trójmiejskiej Akademickiej Sieci Komputerowej.

Rysunek 7. Karuzelowy

zmieniacz dysków optycznych na 240 dysków (Kubik 240 M Jukebox). Odczyt

równoległy poprzez 4 napędy CD. Interfejs SCSI-2. Zdjęcie autora.

Rysunek 8.

Archiwizator taśmowy. Centrum Informatyczne Trójmiejskiej Akademickiej Sieci

Komputerowej. Zdjęcie autora.

Komputery sprzedaje się w

kilku różnych wykonaniach, w zależności od potrzeb odbiorcy. Spośród nich

wymienimy serwery baz danych i stacje robocze. Serwer baz danych jest

przeznaczony do przetwarzania znacznych ilości danych o ustalonej programowo

strukturze. Aby serwer spełniał pokładane w nim oczekiwania, jego czas

odpowiedzi na zlecane mu zadania musi być jak najkrótszy. Jest naiwnością

przypuszczać, że pierwszy-lepszy szybki współczesny komputer osobisty nadaje się

do pełnienia roli serwera bibliotecznego. Szybkość przetwarzania transakcyjnego

bardzo zależy od zegara systemowego, wewnętrznej architektury procesora

(zwłaszcza wielkości oraz cech funkcjonalnych pamięci podręcznej), wreszcie od

szybkości twardych dysków i rodzaju kontrolera, jakie te dyski obsługuje. Last

but not least – ogromnie ważna jest pamięć, od której bardzo zależy moc

przetwarzania serwera. Od rodzaju obsługiwanych protokołów w fundamentalny

sposób zależą wymagania nakładane na budowę serwera. W przypadku serwerów FTP

lub pocztowych, krytyczna jest wydajność dysków serwera, natomiast w przypadku

np. serwerów Z39.50 – bardzo dużą rolę zaczyna odgrywać wielkość pamięci RAM i

zegara systemowego.

Na przełomie lat 2000/2001 w

klasie serwerów zaczynają dominować jednostki wieloprocesorowe, ciągle

wykorzystujące technologię krzemową, za to już z wyraźnie obniżonym napięciem

zasilania i wysoką częstotliwością taktowania procesora. Bogatsze instytucje

konfigurują tego rodzaju wieloprocesorowe moduły w klastry posiadające bardzo

dobre parametry użytkowe.

Stacja robocza to stanowisko

komputerowe końcowego użytkownika wyposażone w dostęp do sieci. W odróżnieniu od

serwera, gdzie całkowite koszty inwestycyjne są zdominowane przez licencję

aplikacji, uzależnioną od złożonych czynników (dawniej była to liczba

użytkowników, obecnie ogólna wydajność serwera) – koszt stacji roboczej

determinują urządzenia dostępowe sprofilowane ze względu na użytkownika. Im

mniej spotykane na rynku wymagania ma użytkownik, tym wyposażenie jego stacji

roboczej jest droższe. Najlepiej to widać na przykładzie stanowiska roboczego

osoby niewidomej, w którym to przypadku sprzęt brajlowski niebywale podwyższa

koszt całej inwestycji. Można nawet wypowiedzieć bardzo ogólną opinię, że sprzęt

rehabilitacyjny pozwalający na korzystanie inwalidów z systemu komputerowego

jest bardzo drogi.

Ze sprzętem komputerowym immanentnie związane jest

oprogramowanie. W ogólności dzielimy je na systemowe i użytkowe (aplikacyjne).

Oprogramowanie często przygotowywane jest pod odpowiedniego producenta sprzętu.

Samodzielne składanie komputera i dostrojenie do niego całego osprzętu i

oprogramowania wymaga sporej wprawy, a wiele problemów wychodzi na jaw dopiero

przy instalacji oprogramowania.

Architektura systemu

Rola, jaką w nowoczesnym

systemie cyfrowym odgrywa jego architektura, była kilkakrotnie prezentowana

przez autora na forum bibliotek polskich [Czermiński 1994, 1996, 2000], swoją

pracę poświęcił jej też Radwański [1996]. Nowa wizja technologiczna systemów

masowej obsługi rozdziela przestrzennie odbiorcę od zasobów. W technologii

cyfrowej jest to aż nadto widoczne. Wymieńmy zatem podstawowe bloki

morfologiczne takiego systemu:

Stajnia serwerów

1.1. Strefa produkcyjna

(strefa zasobów chroniona przed użytkownikiem)

1.1.1. Serwer produkcyjny

1.1.2. Serwer dokumentów elektronicznych wysokiej wierności

1.1.3.

Serwer archiwizacyjny (por. Składniki systemu)

1.1.4. Serwer weryfikacyjny

[por. Atkins et al., 1997:359]

1.1.5. Podsystem bezpieczeństwa (ochrona

systemów operacyjnych oraz zasobów składowanych na serwerach)

1.2. Strefa

prezentacyjna (zdemilitaryzowana strefa dla użytkownika)

1.2.1. OPAC

(replika katalogu produkcyjnego)

1.2.2. Serwer FTP

1.2.3. Dokumenty

elektroniczne prezentacyjnej jakości

1.2.4. Serwer pocztowy

1.2.5.

Serwer WWW ogólnego przeznaczenia

2. Stanowiska klienta systemu

2.1. Moduł wprowadzania informacji

2.1.1. Dotykowy (klawiatura, mysz,

czytnik pisma brajlowskiego)

2.1.2. Akustyczny (mikrofon, ultradźwiękowy

skaner linii papilarnych)

2.1.3. Optyczny (video kamera, czytnik kodu

paskowego)

2.1.4. Magnetyczny (dyskietki, przenośne dyski, czytniki kart)

2.1.5. Elektryczny (czytniki pamięci flash, PenDrive)

2.2. Moduł

wyprowadzania informacji

2.2.1. Optyczny (monitor, nagrywarka dysków

optycznych)

2.2.2. Akustyczny (głośnik, słuchawki)

2.2.3. Dotykowy

(monitor brajlowski)

2.2.4. Magnetyczny (dyskietki, wymienne dyski, taśmy)

2.2.5. Elektryczny (czytniki pamięci flash, PenDrive)

3. Infrastruktura

komunikacyjna

3.1. Sprzęt

3.1.1. Sprzęt przełączający (przełączniki,

routery, huby)

3.1.2. Ściany ogniowe

3.1.3. Sprzęt publicznego dostępu

do sieci (moduły integracji z telefonią analogową i cyfrową, telewizją kablową,

cyfrowej sieci radiowej)

3.2. Okablowanie

Z powyższego wynika, że model

systemu ma charakter zatomizowany. Usługi są podzielone na poszczególne serwery.

To niekoniecznie musi oznaczać fizyczne rozbicie oprogramowania na różne

komputery: dwa serwery mogą być zainstalowane na jednym komputerze. Jednakże

fizyczna rozdzielność poszczególnych modułów zwiększa szansę obecności

instytucjonalnej na sieci w przypadku uszkodzenia jednego modułu. Warunkiem

takiej obecności jest zarezerwowanie pewnej przestrzeni informacyjnej w ramach

każdego modułu na monitorowanie aktywności pozostałych modułów systemu. Takie

redundancyjne rozwiązanie byłoby organizacyjną realizacją tworzenia kodu

nadmiarowego korekcji błędu w systemach pamięci. Oczywiście w dyskutowanym tu

wypadku na ogół nie ma możliwości odtworzenia brakującej funkcjonalności

uszkodzonego modułu, ale stworzone zostają warunki do przyspieszenia procesu

usunięcia awarii. W korzystnym przypadku możliwe jest również obudzenie

“śpiącego” serwera awaryjnego sygnałem z sieci (maszyna musi mieć zainstalowaną

funkcję Wake-On-LAN). Szczególnie proste jest zorganizowanie tego dla usług

opartych o darmowe oprogramowanie dostępne na platformie Linuxa (serwery FTP,

WWW, poczty elektronicznej). Takie rozwiązanie okaże się natomiast znacznie

kosztowniejsze w stosunku do firmowych zintegrowanych systemów informatycznych

(systemy zarządzania bazami danych, aplikacje biblioteczne). Właściwym

rozwiązaniem wydaje się być realizacja serwerów strefy prezentacyjnej z systemem

operacyjnym posadowionym w pamięci stałej, lub ze sprzętową blokadą zapisu na

twardych dyskach. Już w tej chwili można kupić takie pamięci w modułach wysokiej

poj emności z preinstalowanym systemem plików (Disk-On-Chip). Tego rodzaju

konstrukcja pozwala na bezpieczną realizację procesów komunikacyjnych pomiędzy

serwerami strefy produkcyjnej, a serwerami strefy prezentacyjnej. Fizyczne

wyniesienie prezentacji OPAC-u do strefy nie chronionej jest jednak pewnym

wyzwaniem technicznym. Ochrona zasobów głównych nie powinna bowiem zauważalnie

obniżać czasu obsługi, ale też nie powinna ułatwiać wprowadzenia potencjalnego

“konia trojańskiego” przez dedykowany kanał transmisyjny. A przecież moduł

prezentacyjny musi mieć możliwość przyjmowania od anonimowego użytkownika zleceń

on-line i retransmisji ich do serwera produkcyjnego. Znalezienie skutecznego

rozwiązania jest tu ciągle wyzwaniem technologicznym oraz intelektualnym. Wydaje

się, że bezpiecznym rozwiązaniem byłaby tutaj limitowana translacja skryptowa

przy całkowitym pozbawieniu serwera prezentacyjnego typowego oprogramowania

środowiska unixowego.

Zaproponowana tu architektura korzysta w pewnym stopniu

z filozofii ścian ogniowych (wydzielenia nie chronionej “strefy

zdemilitaryzowanej”, ang. De-Militarized Zone, DMZ).

Problem dublowania serwera

katalogu głównego jest już od jakiegoś czasu rozwijany na świecie, znamy go na

przykład z Biblioteki Kongresu. Ostatnio szczególny gest wsparcia dla tej idei

okazała jedna z najnowocześniejszych i najbardziej aktywnych bibliotek świata -

Narodowa Biblioteka Norwegii [Brygfield 2001]. Rdzeniem systemu tej biblioteki

są dwa czteroprocesorowe serwery Hewlett-Packarda klasy N z 8 GB RAM,

zintegrowane z systemami macierzy dyskowych i archiwizatorów taśmowych poprzez

strukturę sieci SAN w technologii Fiber Channel. Bez najmniejszych wahań można

podać powyższy przykład jako zasługujący na szczególne wyróżnienie i

naśladowanie.

Bezpieczeństwo

Współczesne informacyjne

systemy cyfrowe należą do systemów masowej obsługi społeczeństwa (takich, jak

np. liczne usługi komunalne), ale wyróżniają się spomiędzy nich swoją pełną

dostępnością w skali globalnej (a nie lokalnej) przez 7 dni w tygodniu i 24

godziny na dobę. Są podobne do stabilizowanego na poziomie narodowym

zaopatrzenia w elektryczność, bez którego niesposób wyobrazić sobie

funkcjonowanie przemysłowych cywilizacji XXI wieku. Jednak w odróżnieniu od

narodowych systemów energetycznych o scentralizowanym zarządzaniu, systemy

cyfrowe na ogół nie mają tak dobrej ochrony, a to ze względu na cechującą je

integrację systemu zarządzania z systemem użytkowym (aplikacją). Wyposażone

przez ich twórców w odpowiednią porcję sztucznej, lecz mocno niedoskonałej

inteligencji, stały się w jakimś sensie odbiciem obecnej epoki, cech i potrzeb

tego społeczeństwa, które je wytworzyło. Reakcja systemów cyfrowych jest bardzo

szybka, choć niekoniecznie zgodna z oczekiwaniami indywidualnymi czy

społecznymi. Jak powszechnie wiadomo, interwencja pojedynczego szaleńca,

mającego uprawnienia administratora systemu, może prowadzić do katastrofy o

niewyobrażalnej skali. O ile jednak szaleniec obejmujący czołowe stanowisko w

administracji państwowej jest w stanie doprowadzić do końcowej katastrofy

dopiero po kilku latach od chwili przejęcia uprawnień, o tyle w systemach

cyfrowych po jednej minucie ze wspaniałej konstrukcji będą już ruiny. Toteż do

najważniejszych składników cyfrowego systemu należą podsystemy nadzoru:

Zagadnienie bezpieczeństwa

jest niezmiernie szerokie i dotyczy praktycznie wszystkich aspektów

funkcjonowania każdego systemu. Było ono przedmiotem troski właścicieli,

projektantów i administratorów systemów cyfrowych już ponad ćwierć wieku temu.

Mimo że wiele głównych problemów nic nie straciło na swej aktualności, to jednak

specyfikacje niektórych niebezpieczeństw grożących systemom informacyjnym z

epoki przed-internetowej brzmią niekiedy zabawnie. Znakomity Peter Naur (ten od

notacji BNF) pisze: "Można rozróżnić kilka

rodzajów wrogów systemu. Konkurenci mogą próbować wydostać tajemnice systemu.

Malwersanci mogą dążyć do zmodyfikowania działania systemu w taki sposób, aby

uzyskać nie należące się im korzyści, na przykład wysokie kwoty na swoich

rachunkach pieniężnych. Wandale mogą podejmować próby fizycznego uszkodzenia

systemu choćby przez podłożenie bomby, ale i przez subtelniejsze metody, na

przykład przez poddanie taśm działaniu przypadkowych pól magnetycznych".

[Naur 1979 strona 316]. Federalne Biuro Śledcze (FBI) opracowało czteropoziomową

charakterystykę przestępców komputerowych, która stanowi swojego rodzaju wzorzec

odniesienia (Machnacz [2000]). Wyróżnione w niej zostały:

Świadomość wagi, jaką należy

przypisywać bezpieczeństwu systemów operacyjnych, bardzo powoli torowała sobie

drogę do należnego jej miejsca. Już w 1976 roku na polskim rynku dostępna była

książka [Colin 1976], poruszająca w ograniczonym aspekcie sprawę bezpieczeństwa

systemu operacyjnego. Znaczący wkład w uporządkowanie spraw związanych z

bezpieczeństwem systemów operacyjnych wniósł Olszewski [1981]. Prawdziwy przełom

w tej sprawie nastąpił jednak w 1983 r., gdy to staraniem Departmentu Obrony USA

wydany został w postaci książkowej spis kryteriów oceny wiarygodności systemów

komputerowych [DoD Trusted Computer System Evaluation Criteria, 1983]. Obecnie

książka ta (znana jako Orange Book z tzw. tęczowej serii) jest dostępna na sieci

pod adresem:

Waga, jaką rząd USA

przywiązywał do sprawy bezpieczeństwa systemów komputerowych, otrzymała pełną

oprawę prawną po wejściu w życie w 1987 roku Computer Security Act. Obecnie,

również u nas, mamy już sporo opracowań na temat bezpieczeństwa systemów

komputerowych. W obszarze systemu operacyjnego UNIX można polecić lekturę

piątego rozdziału książki UNIX. Administracja systemu [Frisch 1996]. Prawdziwym

kompendium jest przede wszystkim Computer Security Basics [Russel, Gangemi

1991]. Przez jakiś czas dostępny był na sieci interesujący dokument zatytułowany

US Military and Government Security Guides and Information. Samemu tylko

bezpieczeństwu systemu, wystawionemu na publiczny dostęp w sieci, poświęcona

została znakomita, prawie 900 stron licząca, praca zbiorowa "Bezpieczeństwo

Internetu" [Atkins et al. 1997], którą bezwzględnie należy polecić wszystkim

władzom, odpowiadającym za bezpieczeństwo danych. W odniesieniu do

bezpieczeństwa różnych mutacji UNIXa można odesłać Czytelnika do 17 rozdziału

sumiennie udokumentowanej książki Warhole [1999]. Z polskich opracowań warto

wymienić bardzo pożyteczne książki Kutyłowskiego i Strothmana [1999], Lidermana

[2000] oraz Wrony [2000]. Pocieszający jest fakt podejmowania ambitnych prac

magisterskich na polskich uczelniach w tematyce dotyczącej szeroko rozumianego

bezpieczeństwa. Dobrym przykładem może tu służyć dokument sieciowy:

http://dyplomy.sk-kari.put.poznan.pl/Tematy/Tematy00.html .

Dla ułatwienia Czytelnikowi poruszania się w obszernej terminologii zagadnień bezpieczeństwa systemów cyfrowych warto zasygnalizować, że Orange Book

definiuje 7 klas bezpieczeństwa:

Od kilku lat istnieją już na

rynku systemy operacyjne o podwyższonym bezpieczeństwie. W roku 1992 firma

Hewlett-Packard ujawniła swoim dystrybutorom, że dysponuje systemem operacyjnym

o nazwie HP-UX B-Level Security Operating System, spełniającym kryteria

bezpieczeństwa na poziomie B1. Produkt ten jest wymieniany m.in. w cytowanej

wyżej książce Warhole[1999:139]. Mimo zapytań kierownictwa Zespołu

Koordynacyjnego ds. Wdrażania VTLS o cenę i dostępność produktu na polskim

rynku, producent nie udzielił wówczas żadnej odpowiedzi. Pytania te powtórzono

jeszcze dwukrotnie: w 1994 oraz 2001, za każdym razem z tym samym skutkiem.

Należy z tego wnioskować, że produkt ten nie jest dostępny dla polskiego

odbiorcy, mimo formalnej przynależności Polski do NATO. Czyżby członkowstwo NATO

mało ukryte kategorie zaufania? Na szczęście firma Hewlett – Packard nie jest

już jedynym dostawcą sprzętu komputerowego, posiadającego system operacyjny o

wysokim poziomie bezpieczeństwa. Obecnie sytuacja jest znacznie lepsza. Firma

SUN Microsystems oferuje Trusted Solaris 8, który od listopada 2000 poddawany

jest testowaniu na spełnianie wymogów klasy B1. Specyfikację techniczną tego

systemu można otrzymać od dystrybutorów komputerów SUN w postaci pliku w

formacie PDF. Dla wielu użytkowników jednak znacznie ważniejszy jest fakt

przeprojektowania Linuxa (kernel 2.2.12 na procesory Intela x86) przez

laboratoria National Security Agency, pod kątem podwyższenia jego

bezpieczeństwa. Podrasowany Linux został wytestowany na dystrybucji Red Hat 6.1

i można go wraz z dokumentacją pobrać z serwera NSA na warunkach GNU General

Public License (http://www.nsa.gov/selinux). Są też

poprawione wersje Linuxa pochodzące od innych producentów. Można je znaleźć na

sieci pod adresami:

http://www.trustix.net// oraz

http://www.bastille-linux.org/. Pożyteczną może się też okazać lektura artykułu Malinowskiego [2002], strony 162-166, omawiającego zabezpieczanie Linuxa poprzez dodanie

odpowiednich łatek.

W tym miejscu warto zachęcić

biblioteki do zainteresowania się systemami operacyjnymi o podwyższonym

bezpieczeństwie. Popularny obecnie na serwerach bibliotecznych UNIX w swej

klasycznej postaci nie jest bezpieczny. Doskonale świadczy o tym przytaczany

przez Bacha [1995:32] diagram blokowy jądra systemu. Na tym diagramie nie widać

obrysu stref bezpieczeństwa i sprawa bezpieczeństwa jeśli jest dyskutowana w tej

książce, to w zakresie minimalnym. Oczywiście można winić za to autora, jednak

prawdziwą przyczyną tego jest nie uwzględnienie spraw bezpieczeństwa

funkcjonowaniania systemu przez jego pierwszych twórców. Jeżeli więc można by

niewielkim kosztem podwyższyć stopień jego bezpieczeństwa, to czemu tego nie

zrobić? Doprawdy trudny do przyjęcia jest brak bezpiecznego systemu

operacyjnego. Z tej pozycji pozostaje tylko apel do zarządców zainstalowanych w

Polsce komputerowych systemów bibliotecznych oraz dyrektorów bibliotek o

wszczęcie uporczywych starań mających na celu posadowienie oprogramowania na

systemach o podwyższonym poziomie bezpieczeństwa. Mimo że administratorzy tych

systemów są bardzo kompetentnymi i zaangażowanymi w swą pracę osobami,

użytkowane przez nich systemy operacyjne są platformami stosunkowo prymitywnymi

i obsługa ich wymaga znacznej uwagi. Administratorom należy dostarczyć wszelkich

dostępnych nowoczesnych narzędzi pracy. Cieszyć się należy, że do chwili obecnej

nie zdarzył się żaden poważniejszy przypadek. Jednak długotrwała sytuacja

bezawaryjna zawsze podwyższa pewność siebie i obniża poziom samokontroli. Tak

upadały wszystkie wielkie imperia.

Reprezentacja obiektów w systemach cyfrowej pamięci

elektronicznej

W systemie cyfrowym operujemy

pewnymi obiektami mającymi wyłącznie postać cyfrową. Na przełomie XX i XXI wieku

powszechnie realizowanym fizycznie wewnętrznym zapisem liczb w systemach

komputerowych jest zapis dwójkowy (binarny), a to ze względu na jego techniczną

prostotę. Do niedawna były poważne trudności z uzyskaniem stabilnych, leżących

blisko siebie, ale zarazem rozróżnialnych i licznych (więcej niż 2) fizycznych

stanów materii. Zapis dwójkowy natomiast daje się stosunkowo prosto zrealizować

od strony technicznej. Rozumieć jednak należy, że w pamięci maszyny nie rezydują

prawdziwe "jedynki" i "zera". Tam w procesie zapisu i wymazywania informacji

wytwarzane są dwa w miarę dobrze wyróżnione stany materii, które symbolicznie

utożsamiamy z "jedynką”, czy też "zerem". Dla przykładu podamy, że w serii

standardowej cyfrowych układów scalonych TTL (ang. Transistor-Transistor Logic)

przyjmuje się

[17], że na wyjściu bramki logicznej jest stan "zero", jeśli napięcie na nim mieści się w granicach 0,0 - 0,4 V, a stan "jeden" - jeśli mieści się ono w przedziale 2,4 - 5,0 V. Obydwa stany

przedzielone są 2 - woltową "przestrzenią niczyją", swojego rodzaju strefą

zdemilitaryzowaną. Ten nadmiarowy, redundancyjny obszar bezpieczeństwa zajmuje w

układach TTL 40% całego operacyjnego interwału napięciowego. To niemała wartość.

W najnowszych systemach cyfrowych z zasilaniem 1,2 V przestrzeń redundancyjna

rozdzielająca "jedynkę" od "zera" została już zmniejszona do 17% całego

przedziału napięciowego, co wyraża swego rodzaju podwyższone zaufanie

projektantów do stosowanej technologii.. Owa przedziałowa definicja stanów

logicznych może ułatwi czytelnikowi zrozumienie, jak trudnym musi być fizyczna

realizacja zapisu cyfrowego i jak ważnym czynnikiem jest stabilizacja warunków

jego pracy (w tym chłodzenia). Wreszcie jak niedaleko stąd do sytuacji, kiedy

komputer będzie realizował paranoiczne operacje na zniekształconych danych. Mamy

tu przecież do czynienia z sytuacją, w której jednemu poziomowi logicznemu

("zero") przypisane jest continuum liczb rzeczywistych z pierwszego cytowanego

przedziału, a stanowi logicznemu "jeden" - continuum liczb z przedziału

drugiego. Realistycznie rzecz biorąc, jest tu jakaś forma konwersji logiki

rozmytej (ang. fuzzy logic) do logiki dwuwartościowej - boolowskiej. Grozą zieje

wizja potencjalnego zachowania się półprzewodnikowych, cyfrowych układów

scalonych w warunkach wysokiej radiacji, gdy większość złącz p-n wchodzi w stan

przewodzenia. W tych warunkach jest rzeczą całkowicie zrozumiałą, że do tej

chwili nie udało się zaprojektować żadnego robota, który był by w stanie wjechać

do wnętrza osławionego czernobylskiego "sarkofagu" celem rozpoczęcia usuwania

zeń paliwa reaktorowego. O wojnie jądrowej lepiej już nie myśleć. Mimo tych

kasandrycznych rozważań faktem jest, że systemy oparte na takich rozwiązaniach

technologicznych działają w normalnych warunkach - i to na ogół znakomicie.

Kończąc komentarze na temat reprezentacji obiektów cyfrowych w systemach

pamięci elektronicznej, poruszymy jeszcze jeden ważny aspekt stosowania

wewnętrznej, dwójkowej reprezentacji liczb. W zapisie dwójkowym mamy tylko 4

reguły mnożenia. Tabliczka mnożenia w systemie dziesiętnym (zmora matematyczna

uczniów szkół podstawowych) dla bezdusznych maszyn została ograniczona w

systemie dwójkowym do strawnego minimum. Pojedyncze quantum informacji nazywa

się tu bitem. W konwencji liczbowej bit może przyjmować wartość 0 lub 1.

Najmniejszą, adresowalną porcję informacji nazywa się bajtem (ang. byte). Zwykle

bajt utożsamia się z uporządkowanym ciągiem 8 bitów.

Czy jednak

arytmetyka binarna jest nieuchronnie związana z systemami cyfrowymi? Z pewnością

nie. Nie można wykluczyć pojawienia się w przyszłości systemów wykorzystujących

więcej niż dwa stabilne stany materii i migracji obecnych systemów dwójkowych do

trójkowych, a nawet jeszcze wyższego rzędu. Od czasu słynnego eksperymentu Barta

J. Van Weesa z 1987 r., w którym określił on warunki kwantowania prądu

elektrycznego w nanobwodach, zaistniały technologiczne okoliczności realizacji

arytmetyki ponad-binarnej w układach scalonych. Dlatego nie należy uważać, że

"cyfrowość" jest immanentnie związana z arytmetyką binarną, jak to niekiedy się

sądzi.

Wielu polskim bibliotekarzom

digitalizacja często kojarzy się z procesem retrokonwersji katalogu kartkowego.

Pojęcie to jest jednak znacznie szersze. Pragnienie umieszczenia czegokolwiek w

systemie cyfrowym musi prowadzić do utworzenia c yfrowego obrazu obiektu

rzeczywistego. Proces taki odnosimy do obiektów nie-cyfrowych i nazywamy

digitalizacją (cyfryzacją). Posługując się programem graficznym kolorowy rysunek

możemy wytworzyć na komputerze od razu w postaci cyfrowej. Przerobienie do

postaci cyfrowej podobnego obrazka, który został namalowany ręcznie, wymaga

posłużenia się skanerem, albo kamerą cyfrową.

Głównym elementem dokonującym

tej konwersji jest przetwornik analogowo-cyfrowy (ang, Analog-to-Digital

converter, ADC, A/D converter). Wzorcowy obraz w czasie skaningu oryginału jest

rozłożony na swego rodzaju tabelę prostokątną składającą się z punktów

(pikseli). Zagęszczenie tych punktów zależy od rodzaju wykorzystywanej matrycy

fotodetekcyjnej, serwomechanizmu skanera oraz życzenia użytkownika, a

zewnętrznie jest reprezentowane rozdzielczością skanowania, wyrażaną w liczbie

punktów przypadającej na jeden cal linii skanowanego oryginału (ang. dots per

inch, dpi). Żeby odczuć skalę tych wartości podamy, że typowy zrzut ekranu w

postaci pliku komputerowego waha się od 72 dpi do 95 dpi, zalecana rozdzielczość

do skanowania tekstu, który ma być rozpoznawany optycznie programem OCR wynosi

300 dpi, typowy wydruk z drukarki laserowej charakteryzuje się zdolnością

rozdzielczą 300 dpi, natomiast do celów poligraficznych zdolność rozdzielcza nie

powinna być niższa od 600 dpi.

Jeśli skanowaniu podlega obraz

barwny, i barwy nie mają być konwertowane do głębi szarości, to w prostych

urządzeniach każdemu punktowi system będzie przypisywał trzy składowe barwne:

czerwoną (ang. Red), zieloną (ang. Green) i niebieską (ang, Blue)

[19]. W uproszczeniu, wg powyższego schematu RGB, polega to na trzykrotnym odczytaniu wielkości sygnału przechodzącego przez wymienione barwne filtry i skonwertowaniu

go przetwornikiem A/D do postaci cyfrowej. Im przetwornik ma lepszą zdolność

rozdzielczą, tym skaner pozwala na uzyskanie większej głębi koloru. Do prostych

zastosowań, jak np. ilustracje do stron internetowych, całkowicie wystarczy

przypisanie każdej składowej czterech bitów. Na czterech bitach można

reprezentować szesnaście poziomów nasycenia każdej komponenty barwnej.

Przynajmniej raz popatrzmy jakie są to układy bitów:

Tabela 1. Lista

poziomów nasycenia komponenty barwnej (4 bity). Opracowanie autora.

| 0000 | 0001 | 0010 | 0011 | 0100 | 0101 | 0110 | 0111 | 1000 | 1001 | 1010 | 1011 | 1100 | 1101 | 1110 | 1111 |

Razem daje to możliwość

przybliżenia skanowanego oryginału paletą wykorzystującą 16*16*16= 4096 różnych

kolorów. Mówimy, że taka digitalizacja daje 4+4+4=12 bitową głębię koloru.

Analogicznie rzecz wygląda przy skanowaniu z większą głębią kolorów. Jeśli

jesteśmy w stanie rozpoznać nasycenie każdej składowej w zmieniającej się od 0

do 255 (8-bitowa skala), to będziemy mówić o 24-bitowej głębi koloru (nazywanej

po angielsku true color /”prawdziwy kolor”), w której system ma formalne

możliwości rozróżnienia 256*256*256 = 16 777 216 różnych kolorów.

W powyższym myślowym

doświadczeniu przeprowadzaliśmy próbkowanie obiektu (ang. sampling) i każdemu

punktowi płaszczyzny oryginału przypisywaliśmy pewną liczbę (tutaj był to

uporządkowany ciąg trzech liczb). Z jednej strony próbkowanie przeprowadzane

było poprzez lokalizację geometryczną analizowanego punktu – możemy więc

powiedzieć, że w tym konkretnym eksperymencie próbkowaliśmy najpierw przestrzeń

[20] kartezjańską. Wynikiem tego

pierwszego próbkowania było przypisanie każdemu punktowi digitalizowanego

oryginału uporządkowanej pary dwóch liczb – jego współrzędnych kartezjańskich

(skanowanym oryginałem był obiekt płaski, 2-wymiarowy).

W każdym punkcie

przeprowadzaliśmy dodatkowe, nowe próbkowanie. Dodatkowemu egzaminowaniu

podlegały jego cechy kolorystyczne, a więc zdolność do selektywnej absorbcji

pewnych długości fal, należących do zakresu widzialnego fal

elektromagnetycznych. Powiemy, że dla każdego punktu przestrzeni kartezjańskiej

próbkowaliśmy przestrzeń częstotliwości promieniowania odbitego od oryginału (w

przypadku skanowania refleksyjnego) dla trzech standardowych częstotliwości

światła.

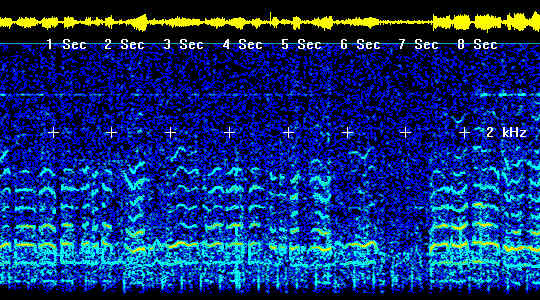

Podobne próbkowanie dla

dźwięku możemy przeprowadzić w przestrzeni czasu. Znakomitą monografię

poświęconą digitalizacji dźwięku wydał ostatnio Czyżewski [1998].

Za wynik digitalizacji

oryginału uznajemy superpozycję (złożenie) procesów próbkowania ze wszystkich

przestrzeni, wraz ze sprzężoną z tymi próbkowaniami konwersją sygnału

analogowego do wartości cyfrowej. Do każdej próbki (punktu próbkowanej

przestrzeni) „dowieszamy” wektor atrybutów. To właśnie na składowych tego

wektora atrybutów dokonuje się algorytmicznych manipulacji, mających na celu

kompresję cyfrowego obrazu, - a więc tak pożądanego zmniejszenia fizycznej

objętości wynikowego zbioru cyfrowego.

Produktem końcowym nie są

jednak same dane binarne, ale plik (ang. file) komputerowy obejmujący oprócz

cyfrowej reprezentacji obrazu również inne elementy, takie jak oznaczenie

początku zbioru cyfrowego, liczbę jego elementów oraz oznaczenie zakończenia. Od

razu trzeba jednak uczynić zastrzeżenie. Do chwili obecnej na świecie pojawiło

się już bardzo wiele najrozmaitszych standardów formatowania danych. Z faktu, że

posiadamy jakiś plik cyfrowy wcale nie wynika, że będziemy potrafili go

odczytać. Do ponurych żartów należy to, że wielcy producenci oprogramowania

wcale się nie wstydzą, że w rodzinie ich własnych produktów nie obowiązuje wcale

zasada "zgodności wstecz" (ang. backward compatibility). Typowy dokument - plik

cyfrowy napisany pod edytorem Word 97 bez dodatkowej konwersji był nie do